Miten kerätä 100+ Aiheeseen liittyvät kysymykset kohdeavainsanoja varten

Viimeksi päivitetty lauantaina 11. marraskuuta 2023

Miten sivustosi voi siis raivata paikkansa verkon tarjoamissa laajoissa tuloksissa? No, vastaukset saattavat piillä kysymyksissä!

Tämänpäiväisessä artikkelissa rakennamme "Ihmiset kysyvät myös" -kaapimen, jonka avulla voit kerätä satoja (tai jopa tuhansia) toisiinsa liittyviä kysymyksiä kohdeavainsanojesi ympärille, jolloin voit rakentaa kattavamman aiheklusterin, optimoida sisältösi ja parantaa hakuaikeita.

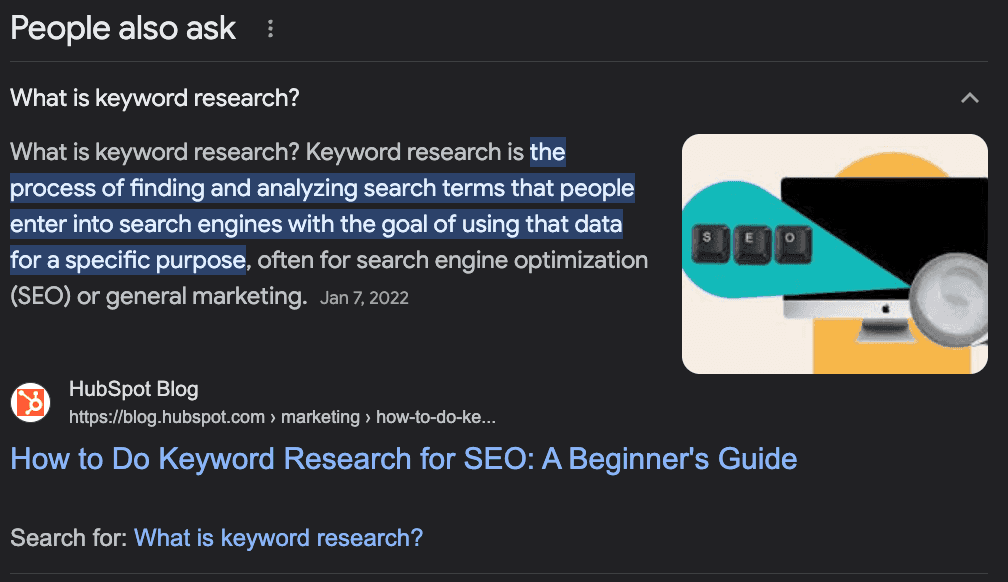

Mikä on "People Also Ask"?

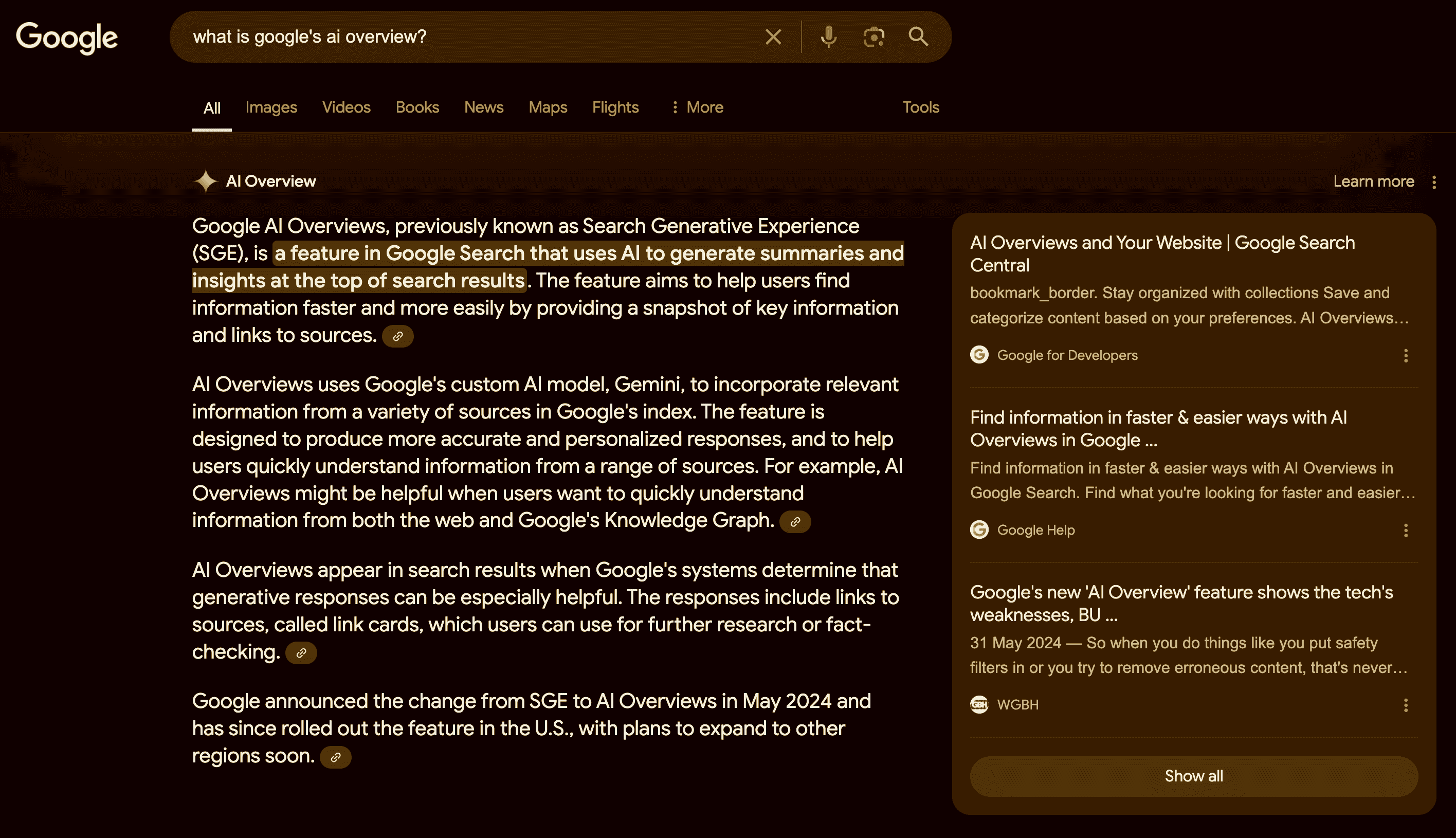

Googlen "Ihmiset kysyvät myös" -toiminto on hakutulosten osio, joka näyttää aiheeseen liittyviä kysymyksiä ja vastauksia muista lähteistä. Se auttaa käyttäjiä löytämään lisätietoja kyselystään tai tutkimaan aiheen eri näkökohtia.

Ominaisuus on dynaaminen ja voi laajentua tai muuttua käyttäjän vuorovaikutuksen mukaan.

Kuinka käyttää PAA-kysymyksiä SEO:n tehostamiseen?

Vaikka "People Also Ask" (PAA) on pääasiassa loppukäyttäjien ominaisuus, se voi olla suuri liittolainen sivustosi sisällön luomisessa ja optimoinnissa.

PAA:n ideana on auttaa käyttäjiä löytämään lisätietoa kyselystään tai auttaa eksyneitä käyttäjiä, jotka eivät ole varmoja siitä, miten tietoa haetaan, joten Googlen on "ennustettava" haun taustalla oleva tarkoitus.

Ymmärrätkö nyt idean?

PAA-kysymykset ovat erinomainen tapa tunnistaa mahdollisia kysymyksiä, joihin sisältösi pitäisi vastata - aiheen auktoriteettia kasvattaen - tai uusia aiheita, joiden pohjalta voit luoda sisältöä päähakusanasi ympärille.

Sanotaan esimerkiksi, että haluat kirjoittaa artikkelin avainsanatutkimuksen tekemisestä. Mitä sinun pitäisi käsitellä?

Useimmat ihmiset etsivät Googlesta kohdetermiä, katsovat, mitä on jo sijoittunut, ja lopettavat.

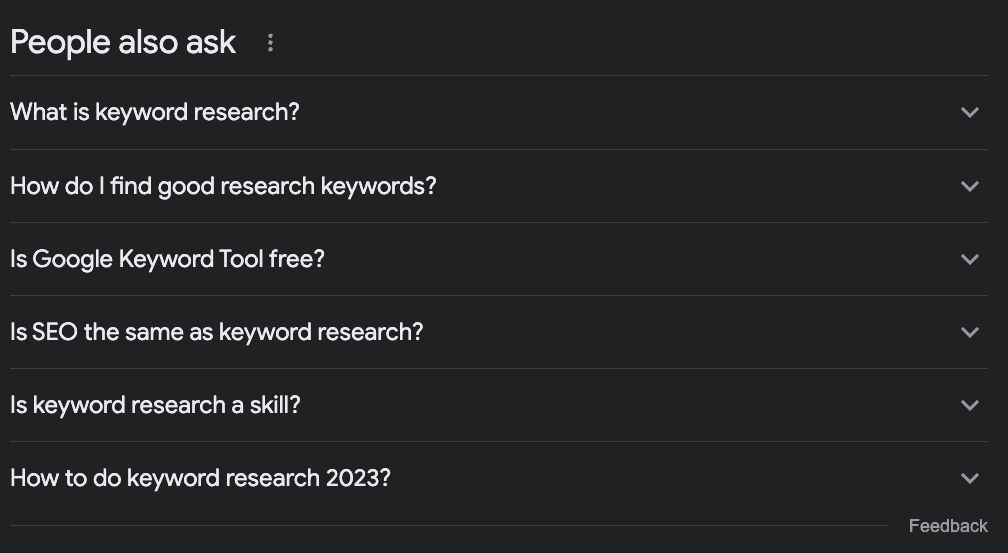

Jos kuitenkin tarkistamme PAA-ruutuun, löydämme mielenkiintoisia ideoita:

Mitä on avainsanatutkimus?

Miten löydän hyviä tutkimusavainsanoja?

Onko Google Keyword Tool ilmainen?

Onko SEO sama asia kuin avainsanatutkimus?

Miten tehdä avainsanatutkimus 2023?

Pelkästään näistä kysymyksistä voimme päätellä muutamia asioita:

Kysymys "Onko SEO sama asia kuin avainsanatutkimus?" kertoo meille, että tämä on hyvin aloitteleva aihe, joten tätä termiä etsivät ihmiset ovat aloittelijoita, ja meidän pitäisi antaa heille sävy.

Kyseessä on kehittyvä aihe, jota on päivitettävä usein, koska meillä on kysymys kuluvasta vuodesta.

Meidän pitäisi lisätä osio otsikoilla "Mitä on avainsanatutkimus?" ja "Miten löydän hyviä hakusanoja" - en käyttäisi toista aivan näin, mutta ymmärrät pointin.

Meidän pitäisi mainita, miten käyttää "Google Keyword Planneria" osana opetusohjelmaa, koska Google sitoo sen hakukyselyyn.

Voimme saada paljon arvokasta tietoa avainsanoistamme, rakentaa luettelon niihin liittyvistä avainsanoista, optimoida sisältöämme vastaamaan yleisiin kysymyksiin kohdeavainsanan ympärillä ja löytää uusia aiheideoita kokonaisten aiheklustereiden rakentamiseksi.

"Ihmiset kysyvät myös" -kysymysten kerääminen Pythonilla

Tässä on kuitenkin yksi haaste. Kaikkien näiden kysymysten kerääminen olemassa olevaa sisältöämme varten tai sisällön suunnittelun tueksi on aikaa ja resursseja vievä tehtävä.

SEO:lla ja sisältömanagerilla on jo nyt paljon työtä lisätutkimusten lisäämiseksi, joten miten ratkaisemme tämän?

Yksinkertaista, automatisoimme prosessin!

Rakennamme verkkokaapimen, joka:

Ottaa luettelon avainsanoista

Siirtyy avainsanan SERP:hen

Pura kaikki PAA-kysymykset

vie tiedot CSV-tiedostoon

Tässä opetusohjelmassa käytämme Pythonia ja yksinkertaista työkalua, joka huolehtii kaikesta monimutkaisuudesta, ja voit käyttää tuloksena olevaa koodia vain muuttamalla avainsanoja.

Oletko valmis? Aloitetaan.

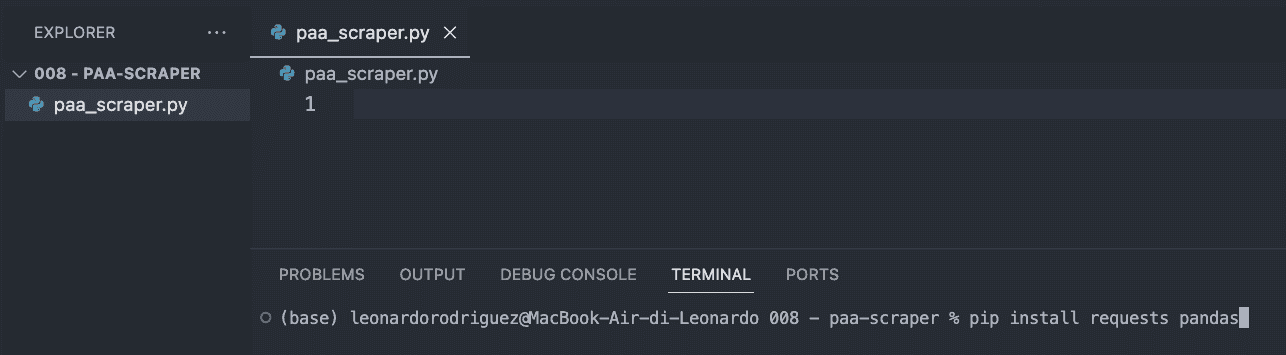

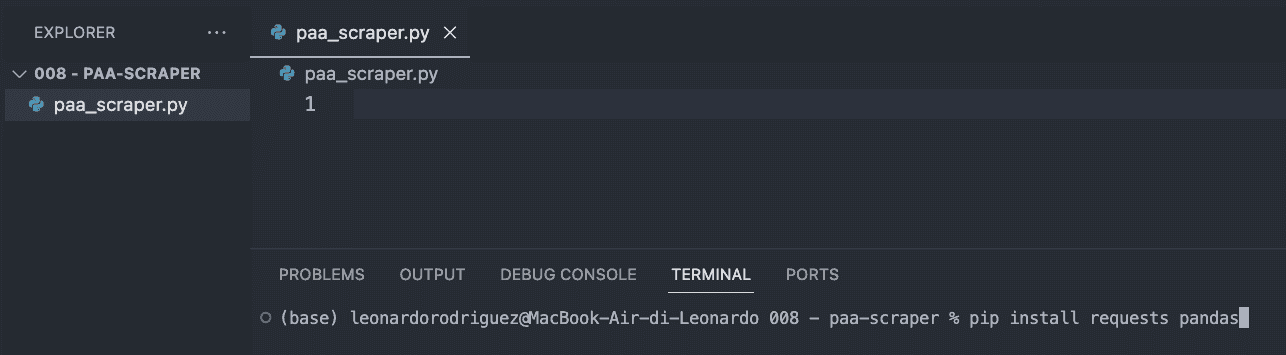

Vaihe 1: Projektin määrittäminen

Ensimmäiseksi luot projektillesi uuden kansion (nimeä se paa-scraper) ja luo sen sisälle uusi paa_scraper.py-tiedosto.

Jos käytät Mac-tietokonetta, koneellesi on jo asennettu Python-versio. Jos käytät Windowsia, noudata tätä ohjetta saadaksesi sen koneellesi.

Avaa kansio seuraavaksi VScodessa ja uudessa terminaalissa.

Kirjoita sieltä seuraava komento.

pip install requests pandasYllä oleva komento asentaa kaksi hyödyllistä työkalua (riippuvuuksia):

Requests antaa meidän kysyä tietoja, jotka haluamme poimia ulos

Pandas auttaa meitä viemään tiedot CSV-tiedostona.

Viimeistele tämä vaihe tuomalla molemmat riippuvuudet tiedoston yläosaan.

import requests import pandas as pdVaihe 2: Pyyntömme lähettäminen ScraperAPI:n avulla

Perinteisesti saadaksemme etsimämme tiedot meidän olisi pitänyt rakentaa scraper, joka navigoi Googleen, etsii tietoja CSS-valitsimien avulla, poimii tiedot, muotoilee ne... tiedätkö mitä tarkoitan? Se on yleensä paljon logiikkaa.

Sen sijaan voimme käyttää verkkokaavintatyökalua, joka vähentää kustannuksia, käyttöönottoaikaa ja ylläpitoa.

Lähettämällä pyyntömme ScraperAPI:n strukturoitujen tietojen päätepisteiden kautta voimme hakea minkä tahansa kyselyn PAA-kysymykset huolehtimatta HTML:n jäsentämisestä, estämisestä tai muista mahdollisista ongelmista.

Aloita luomalla ilmainen ScraperAPI-tili ja kopioi API-avaimesi kojelaudalta.

Sitten luomme hyötykuorman näin:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }Maa-parametri kertoo ScraperAPI:lle, mistä lähettää pyynnöt - muista, että Google näyttää eri tuloksia sijaintisi perusteella - kun taas kyselyparametri sisältää avainsanasi.

Kun nämä parametrit ovat valmiina, voimme lähettää pyyntömme get()-metodilla:

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload).Vaihe 3: PAA-kysymysten tulostaminen

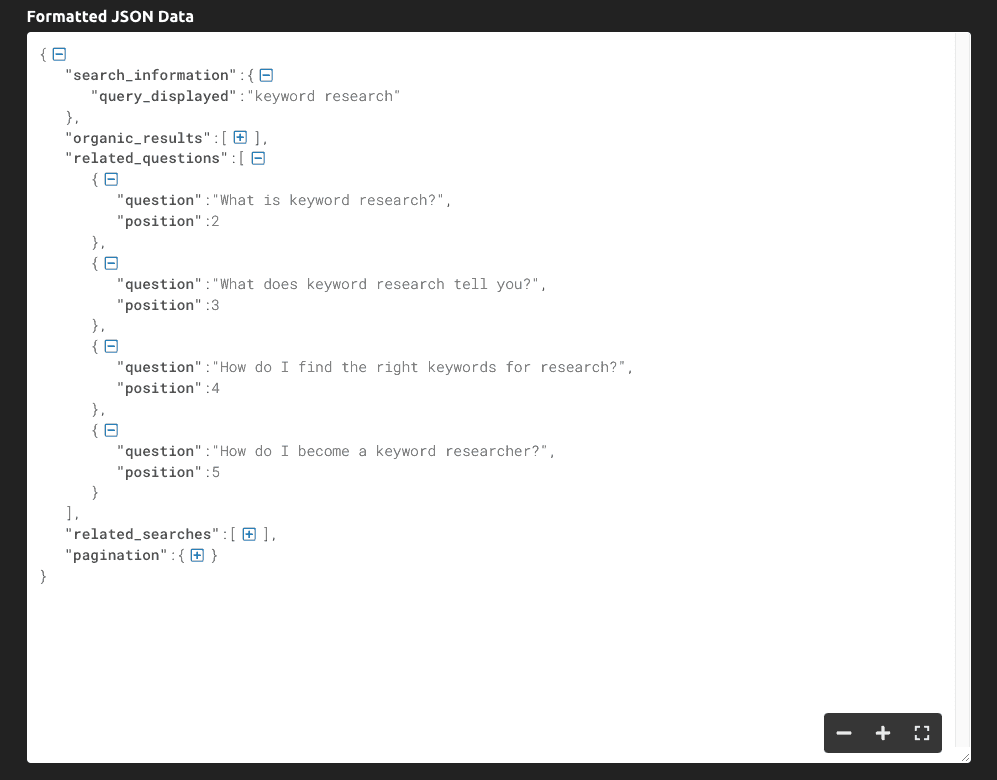

Jos tulostamme(response.text), saamme seuraavat tiedot:

Kuten näet, työkalu palauttaa koko SERP:n JSON-datana, ja kyselyyn liittyvät tärkeimmät kysymykset ovat "related_questions"-avaimen sisällä.

Koska saamme strukturoitua dataa raa'an HTML-datan sijasta, voimme valita tiettyjä elementtejä niiden avainnimen avulla:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])Tallennamme koko JSON-vastauksen serp-muuttujaan

Otamme "related_questions" ja luomme luettelon kohteista, joissa jokainen kohde on PAA-kysymys.

Otamme kysymykset, käymme luettelon läpi ja tulostamme vain "question"-avaimen.

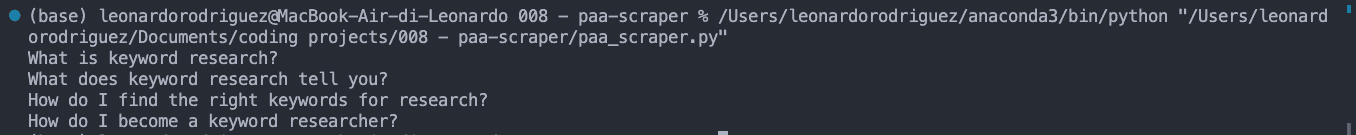

Tuloksena on lista PAA-kysymyksistä, jotka tulostetaan konsoliin:

Vaihe 4: Tietojen vienti CSV-tiedostoon

CSV-tiedostoa varten saatamme myös haluta sovittaa avainsanan PAA-kysymykseen, joten napataan se:

keyword = serp['search_information']['query_displayed']Kun tämä on tehty, luomme tyhjän listan, jota käytämme tietojen muotoilemiseen haluamallamme tavalla:

paa_questions = []Ja liitämme siihen poimitut tiedot:

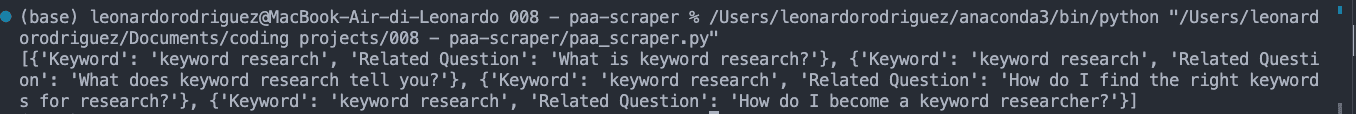

for paa in all_questions: paa_questions.append({ 'Avainsana': avainsana, 'Aiheeseen liittyvä kysymys': paa['kysymys'] })Jos tulostetaan paa_questions, se näyttää konsolissa tältä:

Tämä on tärkeää, koska se on CSV-tiedoston pohja ja auttaa meitä tunnistamaan, mistä kysymys on peräisin, kun laajennamme scraperia tuhansiin avainsanoihin.

Viimeisessä vaiheessa luodaan CSV-tiedosto Pandasin avulla helppoa vientiä varten:

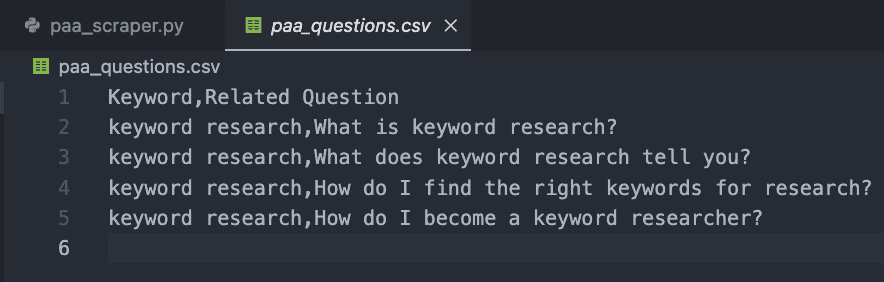

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Jos suoritat koodisi nyt, se ei tulosta mitään konsoliin. Sen sijaan se luo uuden CSV-tiedoston seuraavasti:

Vaihe 5: PAA-kysymysten kerääminen laajassa mittakaavassa

Kysymysten kerääminen vain yhtä avainsanaa varten voidaan tietenkin tehdä käsin, mutta miten skaalaamme tämän projektin?

Tässä on web scrapingin hienous. Kyse on silmukasta!

Luo ensin luettelo haluamistasi avainsanoista:

avainsanat = { 'avainsana+tutkimus', 'avainsana+seuranta' } }Sitten laitamme kaiken edellisen koodimme uuden silmukan sisään, joka ottaa jokaisen avainsanalistan termin ja suorittaa koko prosessin.

Tässä on lopullinen ja täydellinen koodinpätkä:

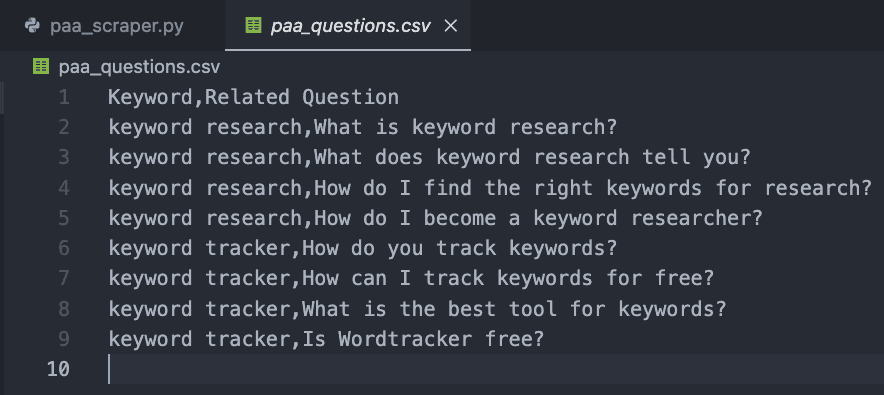

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Testausta varten lisäsimme vain kaksi, mutta voit luoda luettelon tuhansista tai jopa miljoonista kohdennetuista avainsanoista.

Tuloksena on helposti luettava CSV-tiedosto:

Onnittelut, keräsit juuri ensimmäiset 9 PAA-kysymystä! 🎉

Pakkaaminen

Tässä artikkelissa olet oppinut, miten:

Käynnistää uusi Python-kaavin

HTTP-pyyntöjen lähettäminen ScraperAPI:n kautta

Poimia tiettyjä datapisteitä

Muotoile poimitut tiedot

Vie tiedot CSV-tiedostoon

Voit tehdä yllä olevasta koodista oman lisäämällä API-avaimesi ja luettelon avainsanoista keywords-muuttujan sisään. Voit myös käyttää samaa logiikkaa kerätäksesi huippusijoitukset jokaiselle kohdeavainsanalle ja skaalata tutkimustyötäsi automatisoimalla nämä prosessit.

Jos et halua käsitellä koodausta, voit myös käyttää ScraperAPI:n DataPipelinea, joka on kooditon työkalu, joka on suunniteltu automatisoimaan kokonaisia scraping-projekteja kirjoittamatta riviäkään koodia. Lisää vain luettelo avainsanoista ja anna työkalun tehdä loput.

PAA-kysymysten kerääminen ja käyttäminen sivustosi sisällön parantamiseen on salainen ase, jonka useimmat SEO-ammattilaiset jättävät huomiotta. Data on paras ystäväsi, jos osaat käyttää sitä, joten ole luova ja kokeile rajoja, jotta voit hallita markkinarakoasi!

Tarvitsetko keinon seurata SEO-toimintojasi? Aloita Accurankerin ilmainen kokeilujakso ja saat kokonaiskuvan SEO-kampanjastasi muutamalla klikkauksella.

Artikkeli:

Leonardo

Johtava tekninen kirjoittaja ScraperAPI:ssä

Leo on Italiassa asuva teknisen sisällön kirjoittaja, jolla on kokemusta Pythonista ja Node.js:stä. Hän työskentelee tällä hetkellä ScraperAPI:n johtavana teknisenä kirjoittajana ja sisällönhallintapäällikkönä...