Hoe verzamel je 100+ vragen die gerelateerd zijn aan je doelzoekwoorden

Laatst bijgewerkt op zaterdag 11 november 2023

Dus hoe kan uw website een plaats veroveren in de enorme resultaten die het web biedt? De antwoorden liggen misschien wel in de vragen!

In het artikel van vandaag gaan we een "Mensen vragen ook" scraper bouwen om honderden (of zelfs duizenden) gerelateerde vragen rond uw doelzoekwoorden te verzamelen, zodat u een uitgebreider onderwerpcluster kunt bouwen, uw inhoud kunt optimaliseren en de zoekintentie kunt verbeteren.

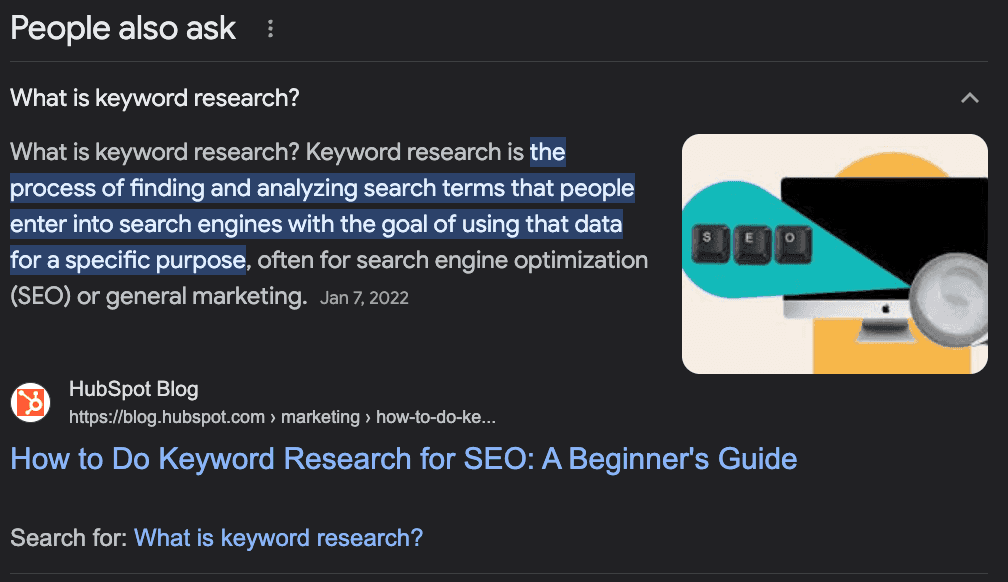

Wat is "Mensen vragen ook"?

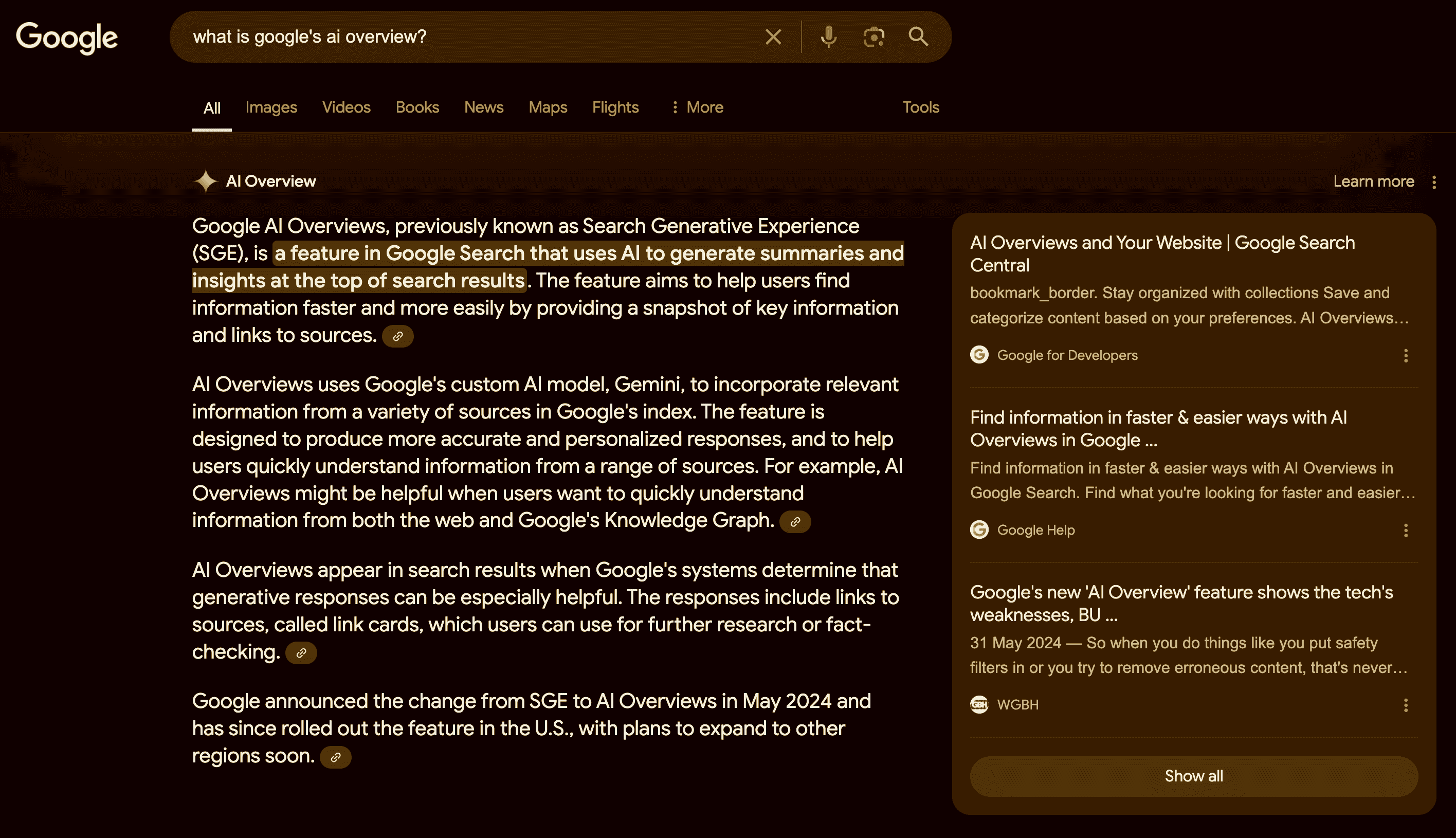

De functie 'Mensen vragen ook' van Google is een gedeelte van de zoekresultaten waarin gerelateerde vragen en antwoorden van andere bronnen worden weergegeven. Het helpt gebruikers meer informatie over hun vraag te vinden of verschillende aspecten van het onderwerp te verkennen.

De functie is dynamisch en kan uitbreiden of veranderen afhankelijk van de interactie van de gebruiker.

Hoe PAA-vragen gebruiken om uw SEO te verbeteren

Hoewel "Mensen vragen ook" (PAA) voornamelijk een functie voor eindgebruikers is, kan het een geweldige bondgenoot zijn bij het maken en optimaliseren van de inhoud van uw site.

Het idee achter PAA is om gebruikers te helpen aanvullende informatie over hun zoekopdracht te vinden of om verdwaalde gebruikers te helpen die niet zeker weten hoe ze naar een bepaalde informatie moeten zoeken, zodat Google de intentie achter de zoekopdracht moet "voorspellen".

Begrijp je het nu?

PAA-vragen zijn een geweldige manier om potentiële vragen te identificeren waarop uw inhoud antwoord zou moeten geven - waardoor de onderwerpautoriteit toeneemt - of nieuwe onderwerpen om inhoud rond uw belangrijkste trefwoord te maken.

Laten we bijvoorbeeld zeggen dat je een stuk wilt schrijven over het doen van zoekwoordenonderzoek. Wat moet je dan behandelen?

De meeste mensen zullen zoeken naar de doelterm in Google, kijken wat er al in de ranking staat en het voor gezien houden.

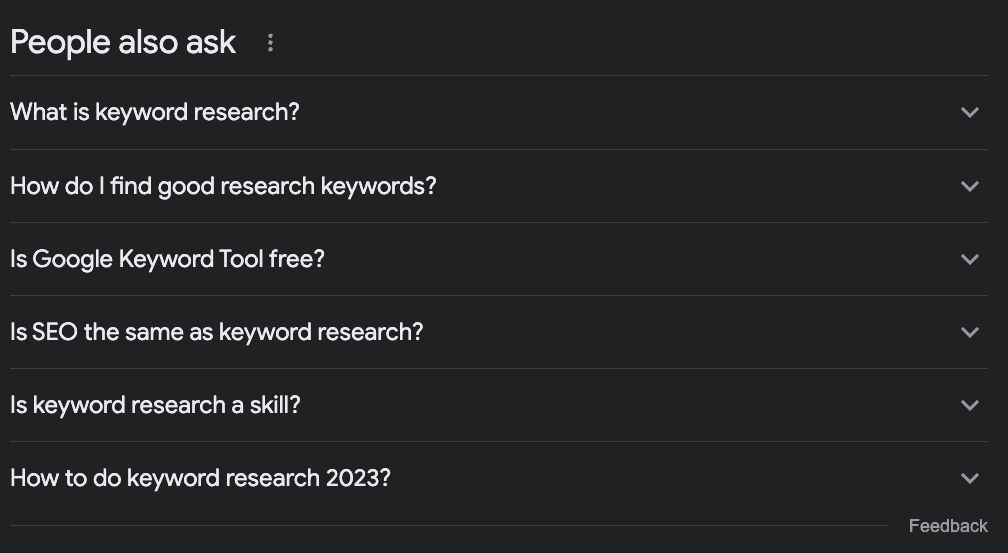

Als we echter het vakje PAA aanvinken, vinden we een aantal interessante ideeën:

Wat is zoekwoordenonderzoek?

Hoe vind ik goede zoekwoorden voor onderzoek?

Is Google Keyword Tool gratis?

Is SEO hetzelfde als zoekwoordenonderzoek?

Hoe doe ik zoekwoordenonderzoek 2023?

Alleen al uit deze vragen kunnen we een paar dingen afleiden:

De vraag "Is SEO hetzelfde als zoekwoordenonderzoek?" vertelt ons dat dit een zeer instaponderwerp is, dus mensen die deze term zoeken zijn beginners, en we moeten de toon voor hen zetten.

Het is een evoluerend onderwerp dat regelmatig moet worden bijgewerkt als we een vraag hebben over het huidige jaar.

We zouden een sectie moeten toevoegen met de kopjes "Wat is Trefwoord Onderzoek?" en "Hoe Vind Ik Goede Zoekwoorden" - ik zou de tweede niet precies zo gebruiken, maar je snapt het punt.

We moeten vermelden hoe we "Google Keyword Planner" kunnen gebruiken als onderdeel van de tutorial, omdat Google dit koppelt aan de zoekopdracht.

We kunnen veel waardevolle informatie krijgen over onze zoekwoorden, een lijst samenstellen van gerelateerde zoekwoorden, onze inhoud optimaliseren om veelvoorkomende vragen rond het doelzoekwoord te beantwoorden en nieuwe onderwerpideeën vinden om complete onderwerpclusters op te bouwen.

Verzamelen van "mensen vragen ook" vragen met Python

Er is echter een uitdaging. Het verzamelen van al deze vragen voor onze bestaande inhoud of om te gebruiken als ondersteuning voor het plannen van onze inhoud is een tijdrovende en arbeidsintensieve taak.

SEO's en contentmanagers hebben al veel werk om extra onderzoek toe te voegen, dus hoe lossen we dat op?

Simpel, we automatiseren het proces!

We bouwen een web scraper die:

Een lijst met zoekwoorden neemt

Naar de SERP van het zoekwoord navigeert

Alle PAA-vragen extraheert

De informatie exporteert naar een CSV

Voor deze tutorial gebruiken we Python met een eenvoudig hulpprogramma dat voor alle complexiteit zorgt, en je kunt de resulterende code gebruiken door alleen de trefwoorden te veranderen.

Klaar? Laten we beginnen.

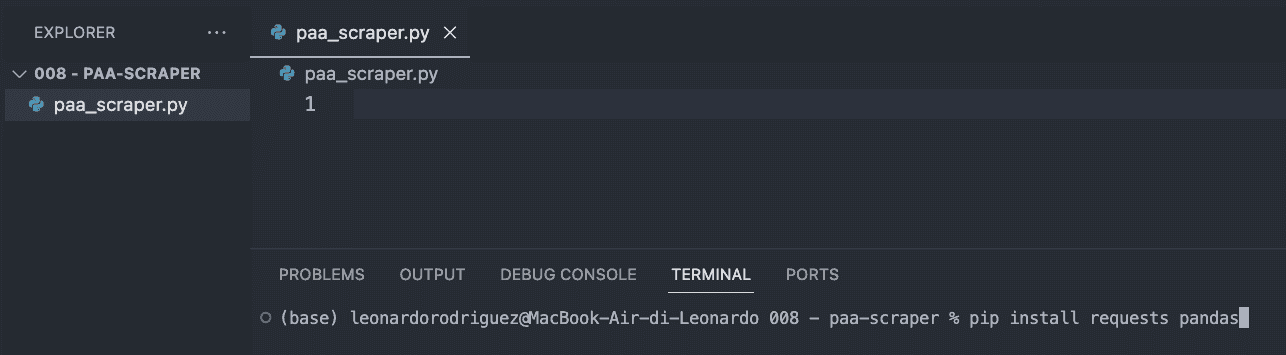

Stap 1: Uw project opzetten

Het eerste wat je moet doen is een nieuwe map aanmaken voor je project (noem het paa-scraper) en daarin een nieuw bestand paa_scraper.py maken.

Als je op Mac werkt, is op jouw machine al een versie van Python geïnstalleerd. Als je Windows gebruikt, volg dan deze tutorial om het op je machine te krijgen.

Open vervolgens de map in VScode en een nieuwe terminal.

Voer vanaf daar het volgende commando in.

pip installeert verzoeken pandasHet bovenstaande commando installeert twee handige tools (afhankelijkheden):

Met requests kunnen we de informatie opvragen die we willen extraheren

Pandas zal ons helpen de informatie te exporteren als een CSV-bestand

Om deze stap te voltooien, importeren we beide afhankelijkheden bovenaan het bestand.

Verzoeken importeren Pandas importeren als pdStap 2: Ons verzoek verzenden via ScraperAPI

Om de gegevens te krijgen waarnaar we op zoek zijn, moeten we traditioneel een scraper bouwen die naar Google navigeert, naar de informatie zoekt met behulp van CSS selectors, de informatie selecteert, formatteert... je begrijpt wat ik bedoel? Dat is meestal een hoop logica.

In plaats daarvan kunnen we een web scraping tool gebruiken om kosten, implementatietijd en onderhoud te verminderen.

Door ons verzoek via de gestructureerde data-eindpunten van ScraperAPI te sturen, kunnen we de PAA-vragen van elke query ophalen zonder ons zorgen te maken over het parsen van de HTML, geblokkeerd te worden of andere problemen waarmee we te maken kunnen krijgen.

Om te beginnen, maak je een gratis ScraperAPI account aan en ga je naar je dashboard om je API sleutel te kopiëren.

Vervolgens maken we een payload zoals deze:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }De landparameter vertelt ScraperAPI waarvandaan het je verzoeken moet sturen - onthoud dat Google verschillende resultaten toont op basis van je locatie - terwijl de queryparameter je trefwoord bevat.

Als deze parameters klaar zijn, kunnen we ons verzoek verzenden met de methode get():

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Stap 3: PAA-vragen afdrukken

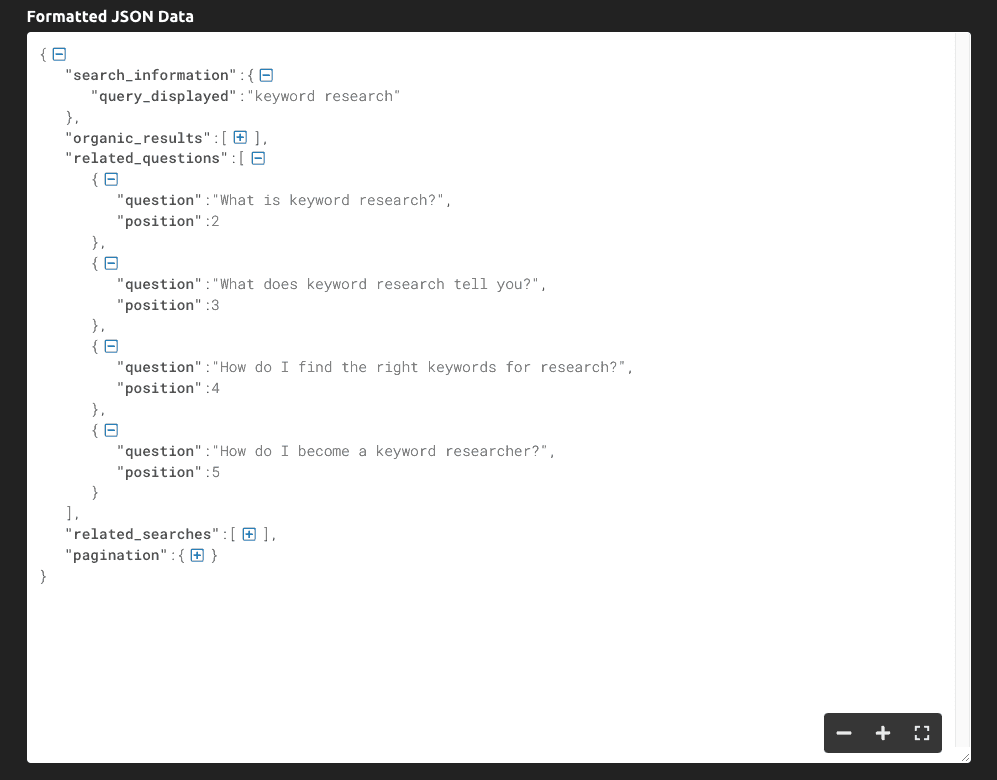

Als we print(response.text) gebruiken, krijgen we de volgende informatie:

Zoals je kunt zien, retourneert de tool de volledige SERP als JSON-gegevens, en de belangrijkste vragen met betrekking tot de query staan in de sleutel "related_questions".

Omdat we gestructureerde gegevens krijgen in plaats van ruwe HTML-gegevens, kunnen we specifieke elementen selecteren met behulp van hun sleutelnaam:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])We slaan het hele JSON antwoord op in een serp variabele

We pakken de "gerelateerde_vragen" en maken een lijst met items - waarbij elk item een PAA vraag is

Om de vragen te pakken, lopen we door de lijst en drukken we alleen de "vraag"-sleutel af

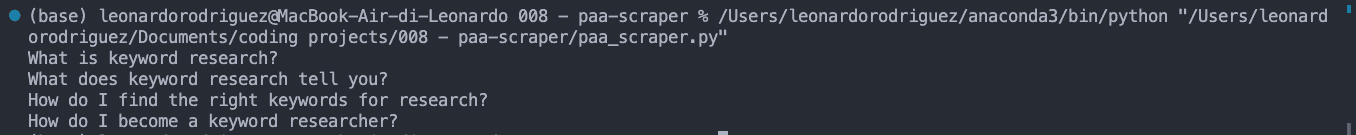

Het resultaat is een lijst met PAA vragen die op de console wordt afgedrukt:

Stap 4: De gegevens exporteren naar een CSV-bestand

Voor het CSV-bestand willen we misschien ook het trefwoord matchen met de PAA vraag, dus laten we het ophalen:

trefwoord = serp['search_information']['query_displayed']Nadat dit is gedaan, maken we een lege lijst die we gebruiken om de gegevens op te maken zoals we willen:

paa_questions = []En voegen de geëxtraheerde informatie eraan toe:

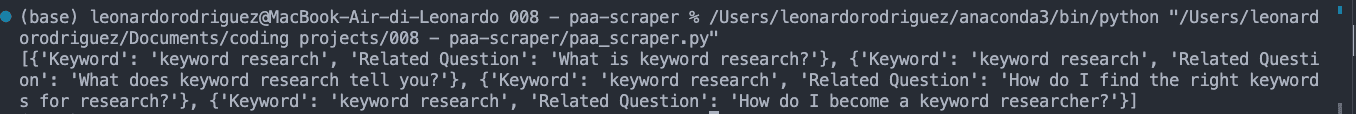

voor paa in alle_vragen: paa_vragen.append({'Trefwoord': trefwoord, 'Gerelateerde vraag': paa['vraag'] })Als we paa_questions afdrukken, ziet het er hier zo uit in de console:

Dit is belangrijk omdat het de basis is van het CSV-bestand en ons zal helpen identificeren waar de vraag vandaan komt als we de scraper uitbreiden naar duizenden trefwoorden.

Laten we voor de laatste stap het CSV-bestand maken met Pandas voor eenvoudige export:

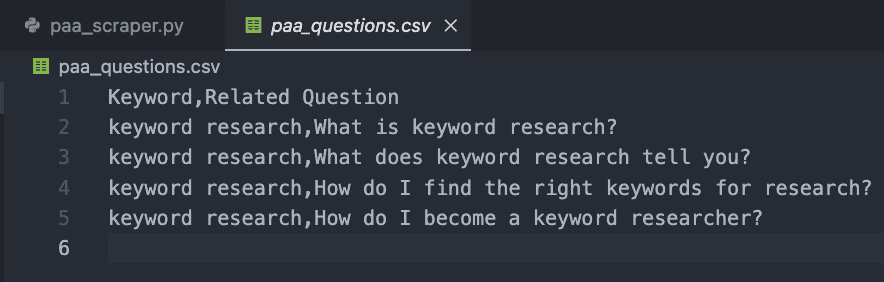

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Als je je code nu uitvoert, wordt er niets op de console afgedrukt. In plaats daarvan wordt er een nieuw CSV-bestand gemaakt zoals dit:

Stap 5: PAA vragen op schaal verzamelen

Natuurlijk kunnen de vragen voor slechts één trefwoord met de hand worden verzameld, dus hoe schalen we dit project?

Dat is het mooie van web scraping. Het draait allemaal om de lus!

Maak eerst een lijst met de gewenste trefwoorden:

keywords = { 'keyword+research', 'keyword+tracker' }Vervolgens plaatsen we al onze vorige code in een nieuwe lus, die elke term in de lijst met trefwoorden neemt en het hele proces uitvoert.

Hier is het uiteindelijke en volledige codefragment:

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Voor testdoeleinden hebben we er maar twee toegevoegd, maar je kunt een lijst met duizenden of zelfs miljoenen gerichte trefwoorden maken.

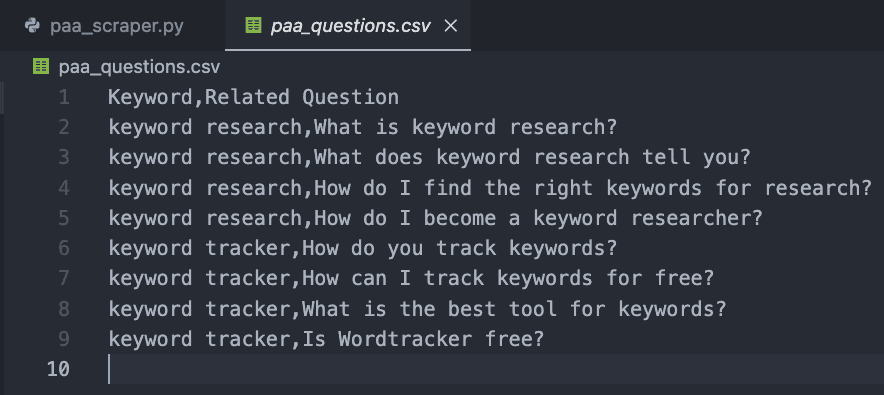

Het resultaat is een eenvoudig te lezen CSV-bestand:

Gefeliciteerd, je hebt zojuist je eerste 9 PAA-vragen verzameld! 🎉

Inpakken

In dit artikel heb je geleerd hoe je:

Een nieuwe Python scraper start

HTTP-verzoeken stuurt via ScraperAPI

Specifieke gegevenspunten kiest

De geëxtraheerde gegevens opmaken

De gegevens exporteren naar een CSV-bestand

U kunt de bovenstaande code zelf maken door uw API-sleutel en een lijst met trefwoorden toe te voegen aan de variabele trefwoorden. U kunt ook dezelfde logica gebruiken om top rankings te verzamelen voor elk trefwoord, zodat u uw onderzoeksinspanningen kunt vergroten door deze processen te automatiseren.

Als je geen codering wilt gebruiken, kun je ook de DataPipeline van ScraperAPI gebruiken, een tool zonder code die is ontworpen om volledige scraping-projecten te automatiseren zonder ook maar één regel code te schrijven. Voeg gewoon je lijst met trefwoorden toe en laat de tool de rest doen.

Het verzamelen en gebruiken van PAA-vragen om de inhoud van je site te verbeteren is een geheim wapen dat de meeste SEO-professionals negeren. Gegevens zijn je beste vriend als je weet hoe je ze moet gebruiken, dus wees creatief en verleg je grenzen om je niche te domineren!

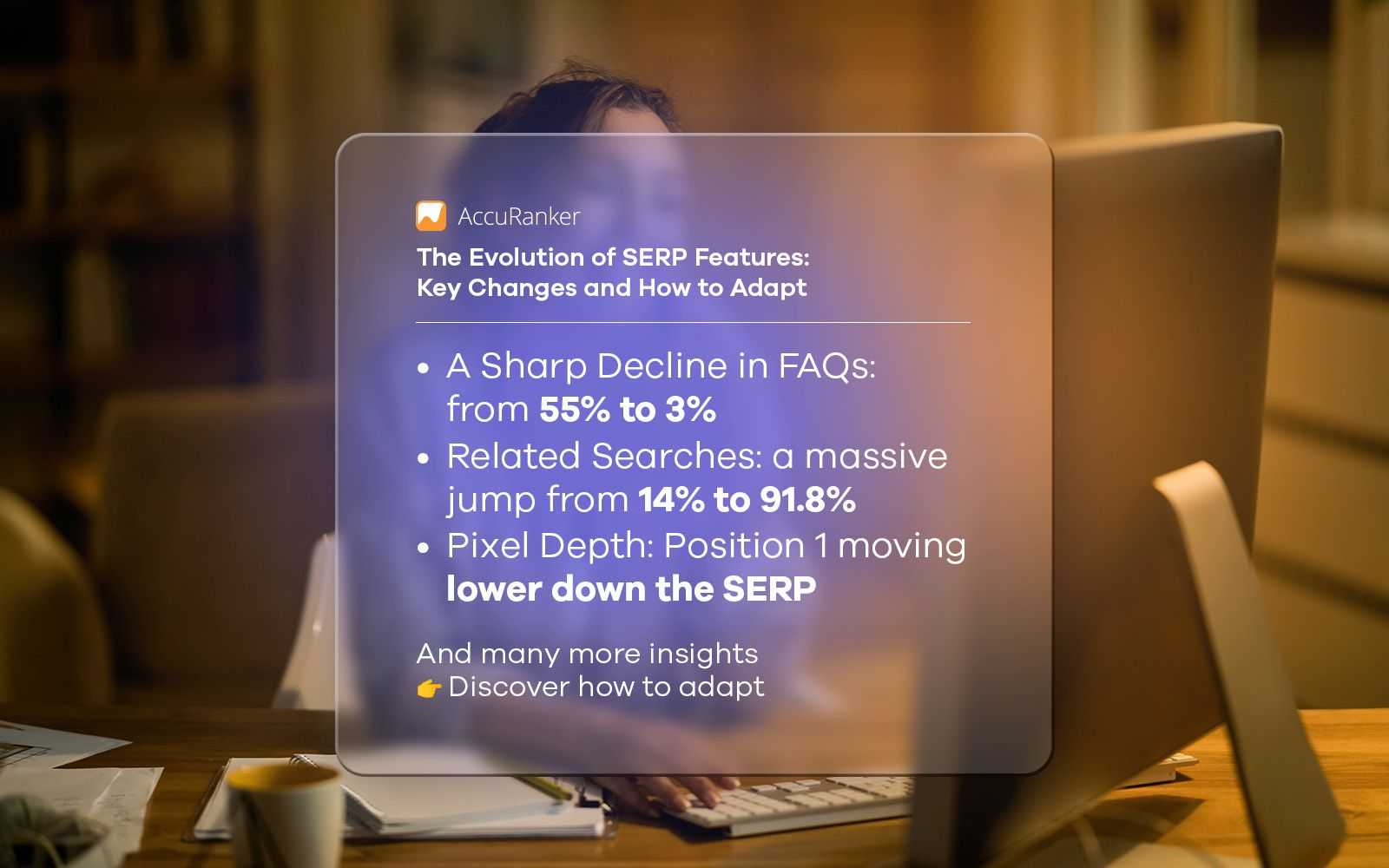

Heb je een manier nodig om je SEO-inspanningen bij te houden? Start uw Accuranker gratis proefversie en krijg een volledig beeld van uw SEO campagne in een paar klikken.

Artikel door:

Leonardo

Technisch schrijver bij ScraperAPI

Leo is een technisch content schrijver gevestigd in Italië met ervaring in Python en Node.js. Hij werkt momenteel bij ScraperAPI als hoofd technisch schrijver en content manager.