Como recolher mais de 100 perguntas relacionadas com as suas palavras-chave alvo

Última atualização em sábado, 11 de novembro de 2023

Então, como é que o seu sítio Web pode conquistar um lugar nos vastos resultados que a Web oferece? Bem, as respostas podem estar nas perguntas!

No artigo de hoje, vamos criar um scraper "As pessoas também perguntam" para recolher centenas (ou mesmo milhares) de perguntas relacionadas com as suas palavras-chave alvo, permitindo-lhe criar um grupo de tópicos mais abrangente, otimizar o seu conteúdo e melhorar a intenção de pesquisa.

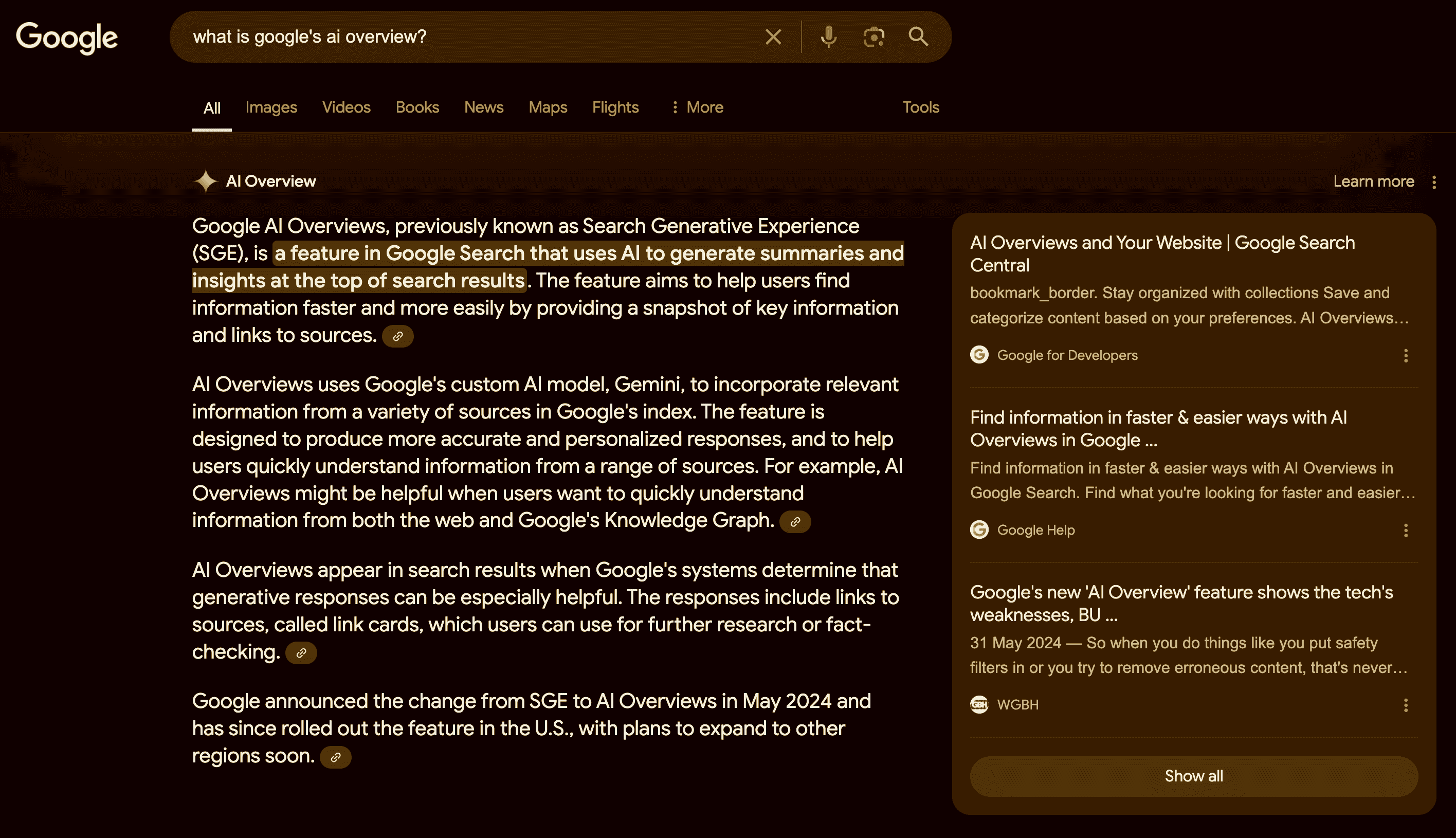

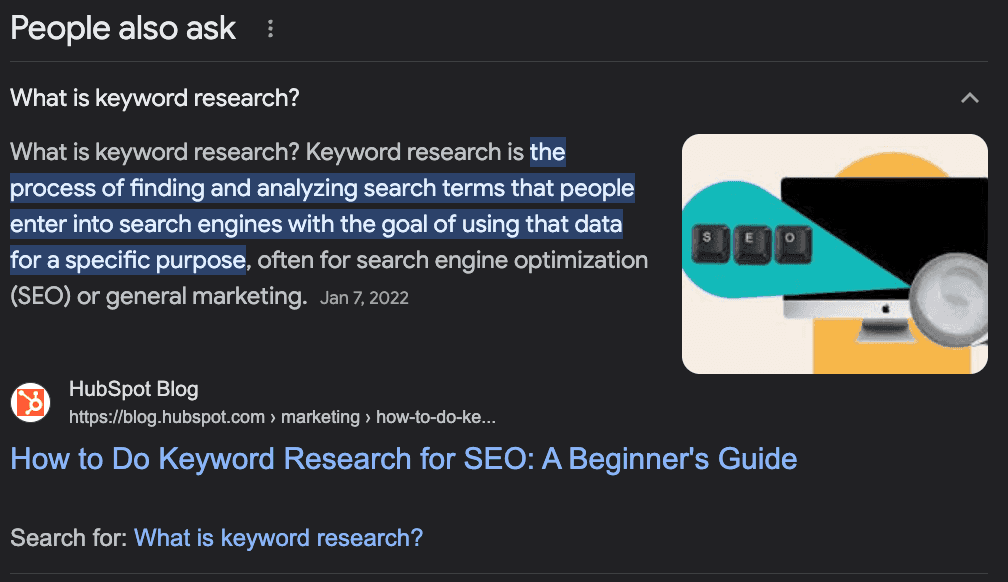

O que é "As pessoas também perguntam"?

A funcionalidade "As pessoas também perguntam" do Google é uma secção dos resultados de pesquisa que mostra perguntas e respostas relacionadas de outras fontes. Ajuda os utilizadores a encontrar mais informações sobre a sua consulta ou a explorar diferentes aspectos do tópico.

A funcionalidade é dinâmica e pode expandir-se ou alterar-se consoante a interação do utilizador.

Como utilizar as perguntas PAA para impulsionar a sua SEO

Embora o "People Also Ask" (PAA) seja principalmente uma funcionalidade do utilizador final, pode ser um grande aliado na criação e otimização do conteúdo do seu site.

A ideia por trás do PAA é ajudar os utilizadores a encontrar informações adicionais sobre a sua consulta ou ajudar os utilizadores perdidos que não têm a certeza de como procurar uma informação, pelo que o Google precisa de "prever" a intenção por trás da pesquisa.

Já percebeu a ideia?

As perguntas do PAA são uma óptima forma de identificar potenciais perguntas a que o seu conteúdo deve responder - aumentando a autoridade do tópico - ou novos tópicos para criar conteúdo em torno da sua palavra-chave principal.

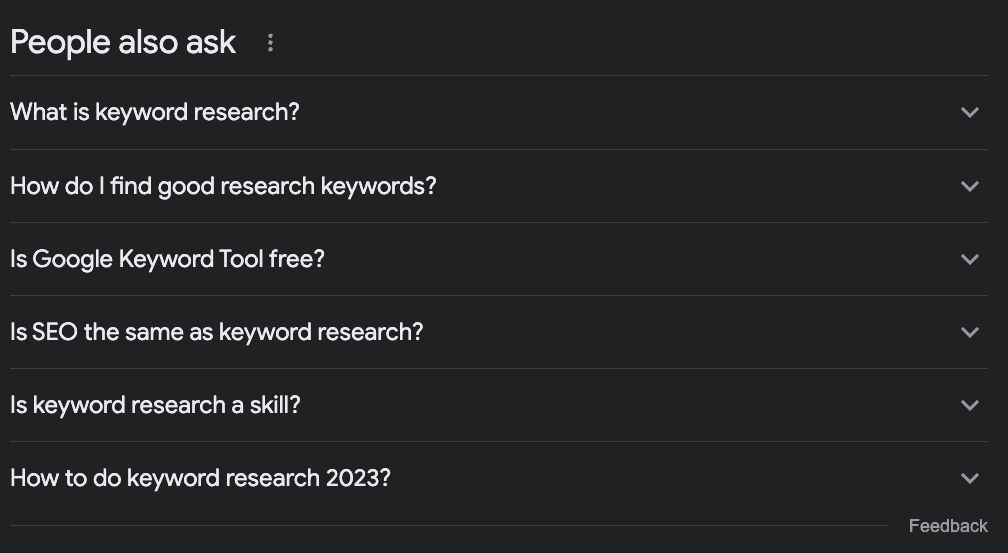

Por exemplo, digamos que quer escrever um artigo sobre como fazer pesquisa de palavras-chave. O que é que deve abordar?

A maioria das pessoas pesquisa o termo alvo no Google, dá uma olhadela no que já está classificado e fica por aí.

No entanto, se verificarmos a caixa do PAA, encontraremos algumas ideias interessantes:

O que é a pesquisa de palavras-chave?

Como é que encontro boas palavras-chave para pesquisa?

A ferramenta de palavras-chave do Google é gratuita?

SEO é o mesmo que pesquisa de palavras-chave?

Como fazer pesquisa de palavras-chave em 2023?

Só com base nestas perguntas, podemos determinar algumas coisas:

A pergunta "SEO é o mesmo que pesquisa de palavras-chave?" diz-nos que este é um tópico muito básico, pelo que as pessoas que pesquisam este termo são principiantes e devemos definir o tom para elas.

É um tópico em evolução que precisa de ser atualizado frequentemente, uma vez que temos uma pergunta sobre o ano em curso.

Devíamos acrescentar uma secção com os títulos "O que é a pesquisa de palavras-chave?" e "Como encontrar boas palavras-chave de pesquisa" - eu não usaria a segunda exatamente assim, mas percebe-se.

Devemos mencionar como utilizar o "Planeador de palavras-chave do Google" como parte do tutorial, uma vez que o Google o associa à consulta.

Podemos obter muitas informações valiosas sobre as nossas palavras-chave, criar uma lista de palavras-chave relacionadas, otimizar o nosso conteúdo para responder a perguntas comuns sobre a palavra-chave alvo e encontrar novas ideias de tópicos para criar grupos de tópicos completos.

Recolha de perguntas "As pessoas também perguntam" com Python

No entanto, há um desafio. A recolha de todas estas perguntas para o nosso conteúdo existente ou para utilizar como suporte para o planeamento do nosso conteúdo é uma tarefa que consome muito tempo e recursos.

Os SEOs e os gestores de conteúdos já têm muito trabalho para adicionar pesquisa extra, por isso, como é que resolvemos isso?

Simples, automatizamos o processo!

Vamos criar um web scraper que:

Pega numa lista de palavras-chave

Navegue até à SERP da palavra-chave

Extrair todas as perguntas do PAA

Exportar as informações para um CSV

Para este tutorial, usaremos Python com uma ferramenta simples para cuidar de toda a complexidade, e você poderá usar o código resultante apenas alterando as palavras-chave.

Pronto? Vamos começar.

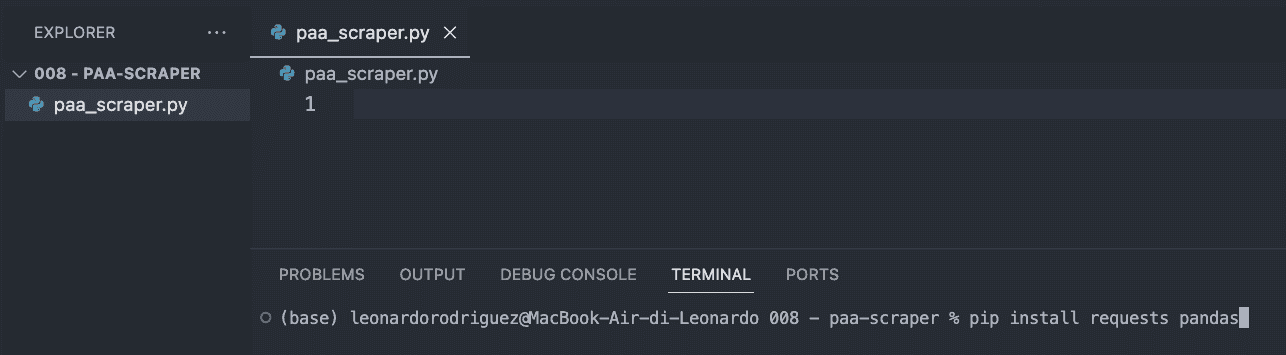

Passo 1: Configurar o seu projeto

A primeira coisa a fazer é criar uma nova pasta para o seu projeto (dê-lhe o nome de paa-scraper) e criar um novo ficheiro paa_scraper.py no seu interior.

Se você estiver no Mac, sua máquina já tem uma versão do Python instalada. Se estiver no Windows, siga este tutorial para instalá-lo em sua máquina.

Em seguida, abra a pasta no VScode e um novo terminal.

A partir daí, digite o seguinte comando.

pip install requests pandasO comando acima instalará duas ferramentas úteis (dependências):

Requests permite-nos pedir a informação que queremos extrair

Pandas nos ajudará a exportar as informações como um arquivo CSV

Para terminar este passo, importe ambas as dependências no topo do ficheiro.

import requests import pandas as pdEtapa 2: Enviando nossa solicitação por meio da ScraperAPI

Tradicionalmente, para obter os dados que procuramos, teríamos de construir um scraper que navegasse até ao Google, procurasse a informação utilizando selectores CSS, escolhesse a informação, a formatasse... percebe o que quero dizer? Normalmente, é muita lógica.

Em vez disso, podemos usar uma ferramenta de raspagem da Web para reduzir custos, tempo de implementação e manutenção.

Ao enviar nossa solicitação por meio dos pontos de extremidade de dados estruturados da ScraperAPI, poderemos recuperar as perguntas do PAA de qualquer consulta sem nos preocuparmos em analisar o HTML, sermos bloqueados ou qualquer outro problema que possamos enfrentar.

Para começar, crie uma conta ScraperAPI gratuita e vá para o painel para copiar sua chave de API.

Em seguida, criaremos um payload como este:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }O parâmetro country dirá à ScraperAPI de onde enviar os seus pedidos - lembre-se que o Google apresenta resultados diferentes com base na sua localização - enquanto o parâmetro query contém a sua palavra-chave.

Com esses parâmetros prontos, podemos enviar nossa solicitação usando o método get():

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Etapa 3: Imprimindo perguntas do PAA

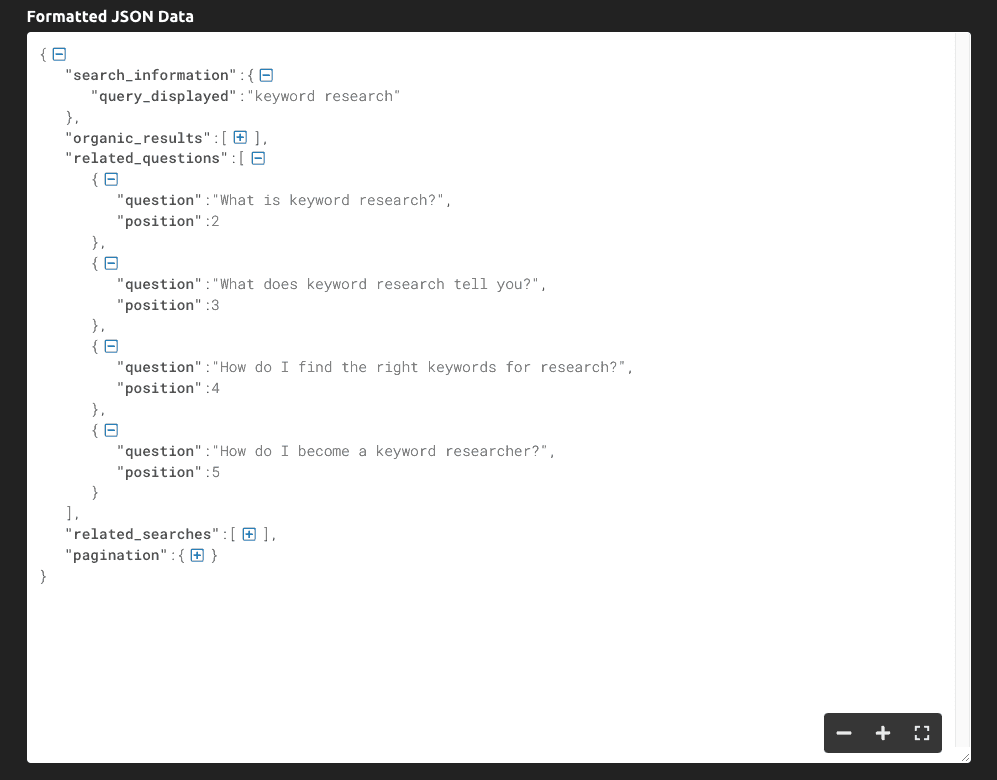

Se imprimirmos(response.text), esta é a informação que obtemos:

Como pode ver, a ferramenta retorna todo o SERP como dados JSON, e as principais perguntas relacionadas à consulta estão dentro da chave "related_questions".

Como estamos obtendo dados estruturados em vez de dados HTML brutos, podemos selecionar elementos específicos usando seu nome de chave:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])Armazenamos toda a resposta JSON em uma variável serp

Pegamos as "related_questions" e criamos uma lista de itens - onde cada item é uma pergunta do PAA

Para obter as perguntas, percorremos a lista e imprimimos apenas a chave "question" (pergunta)

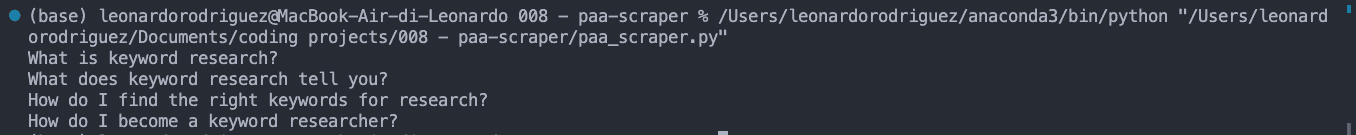

O resultado disso é uma lista de questões do PAA impressa no console:

Etapa 4: Exportando os dados para um arquivo CSV

Para o arquivo CSV, também podemos querer fazer a correspondência da palavra-chave com a questão do PAA, então vamos pegá-la:

keyword = serp['search_information']['query_displayed']Depois de fazer isso, criaremos uma lista vazia que usaremos para formatar os dados como quisermos:

paa_questions = []E anexar as informações extraídas a ela:

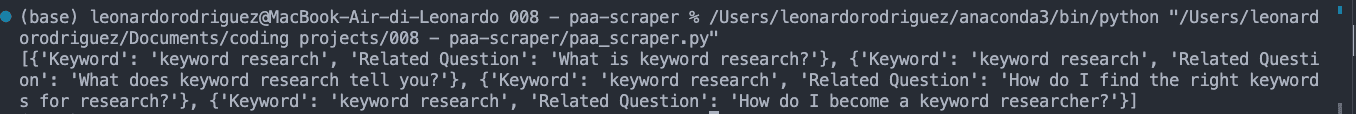

for paa in all_questions: paa_questions.append({ 'Keyword': palavra-chave, 'Related Question': paa['question'] })Se imprimirmos paa_questions, aqui está o aspeto na consola:

Isso é importante porque é a base do arquivo CSV e nos ajudará a identificar de onde vem a pergunta quando expandirmos o scraper para milhares de palavras-chave.

Para a última etapa, vamos criar o arquivo CSV usando o Pandas para facilitar a exportação:

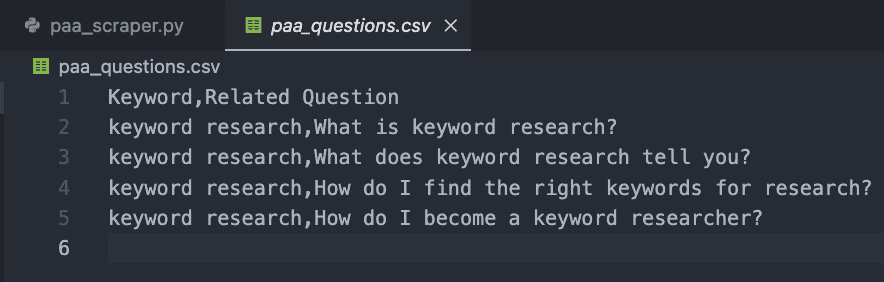

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Se executar o seu código agora, ele não imprimirá nada no console. Em vez disso, ele criará um novo arquivo CSV como este:

Etapa 5: Coleta de perguntas do PAA em escala

É claro que obter as perguntas para apenas uma palavra-chave pode ser feito manualmente, então como podemos escalar esse projeto?

Bem, aqui está a beleza do web scraping. É tudo sobre o loop!

Primeiro, crie uma lista com as palavras-chave desejadas:

keywords = { 'keyword+research', 'keyword+tracker' }Em seguida, colocaremos todo o nosso código anterior dentro de um novo loop, que pegará cada termo dentro da lista de palavras-chave e executará todo o processo.

Aqui está o trecho de código final e completo:

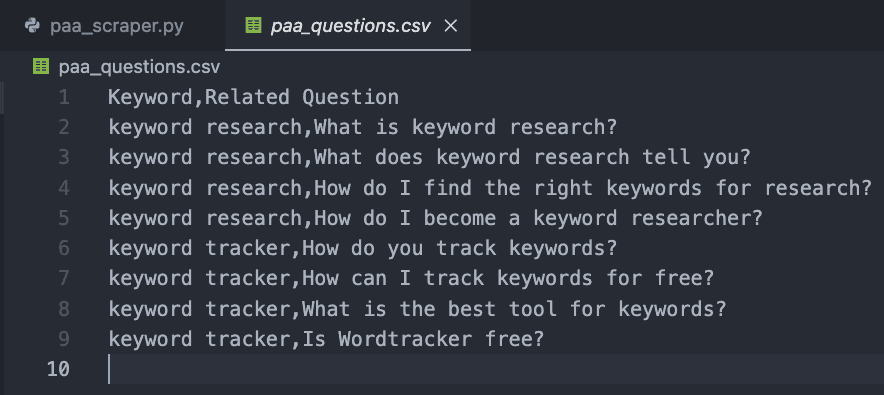

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Para fins de teste, adicionámos apenas duas, mas pode criar uma lista de milhares ou mesmo milhões de palavras-chave direccionadas.

O resultado é um arquivo CSV fácil de ler:

Parabéns, acabaste de recolher as tuas primeiras 9 perguntas do PAA! 🎉

Resumindo

Neste artigo, você aprendeu como:

Iniciar um novo scraper Python

Enviar solicitações HTTP por meio da ScraperAPI

Escolher pontos de dados específicos

Formatar os dados extraídos

Exportar os dados para um ficheiro CSV

Pode tornar o código acima seu, adicionando a sua chave de API e a lista de palavras-chave dentro da variável keywords. Também pode utilizar a mesma lógica para recolher as melhores classificações para cada palavra-chave alvo, aumentando os seus esforços de pesquisa através da automatização destes processos.

Se não quiser lidar com a codificação, também pode utilizar o DataPipeline da ScraperAPI, uma ferramenta sem código concebida para automatizar projectos de scraping completos sem escrever uma única linha de código. Basta adicionar a sua lista de palavras-chave e deixar a ferramenta fazer o resto.

A recolha e utilização de perguntas do PAA para melhorar o conteúdo do seu site é uma arma secreta que a maioria dos profissionais de SEO ignora. Os dados são os seus melhores amigos se os souber utilizar, por isso, seja criativo e ultrapasse os limites para dominar o seu nicho!

Precisa de uma forma de monitorizar os seus esforços de SEO? Inicie a sua avaliação gratuita do Accuranker e obtenha uma imagem completa da sua campanha de SEO com apenas alguns cliques.

Artigo de:

Leonardo

Redator técnico principal na ScraperAPI

Leo é um escritor de conteúdos técnicos baseado em Itália com experiência em Python e Node.js. Atualmente, trabalha no ScraperAPI como redator técnico principal e gestor de conteúdos...