Hedef Anahtar Kelimelerinizle İlgili 100'den Fazla Soru Nasıl Toplanır?

Son g�üncelleme tarihi 11 Kasım 2023 Cumartesi

Peki web siteniz web'in sağladığı geniş sonuçlarda nasıl bir yer edinebilir? Cevaplar sorularda yatıyor olabilir!

Bugünkü makalemizde, hedef anahtar kelimeleriniz etrafında yüzlerce (hatta binlerce) ilgili soruyu toplayarak daha kapsamlı bir konu kümesi oluşturmanıza, içeriğinizi optimize etmenize ve arama amacını geliştirmenize olanak tanıyan bir "People Also Ask" kazıyıcı oluşturacağız.

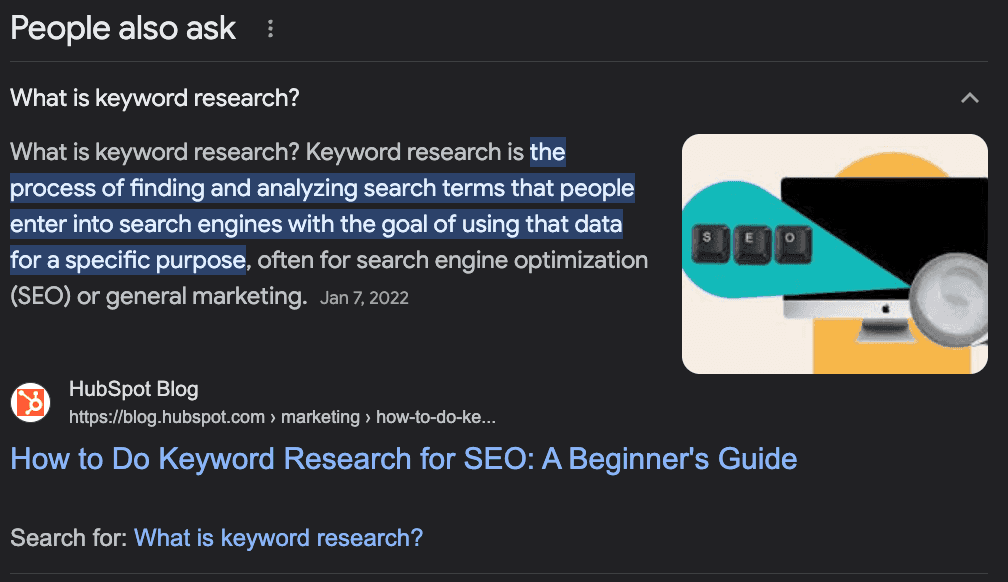

"İnsanlar Ayrıca Soruyor" nedir?

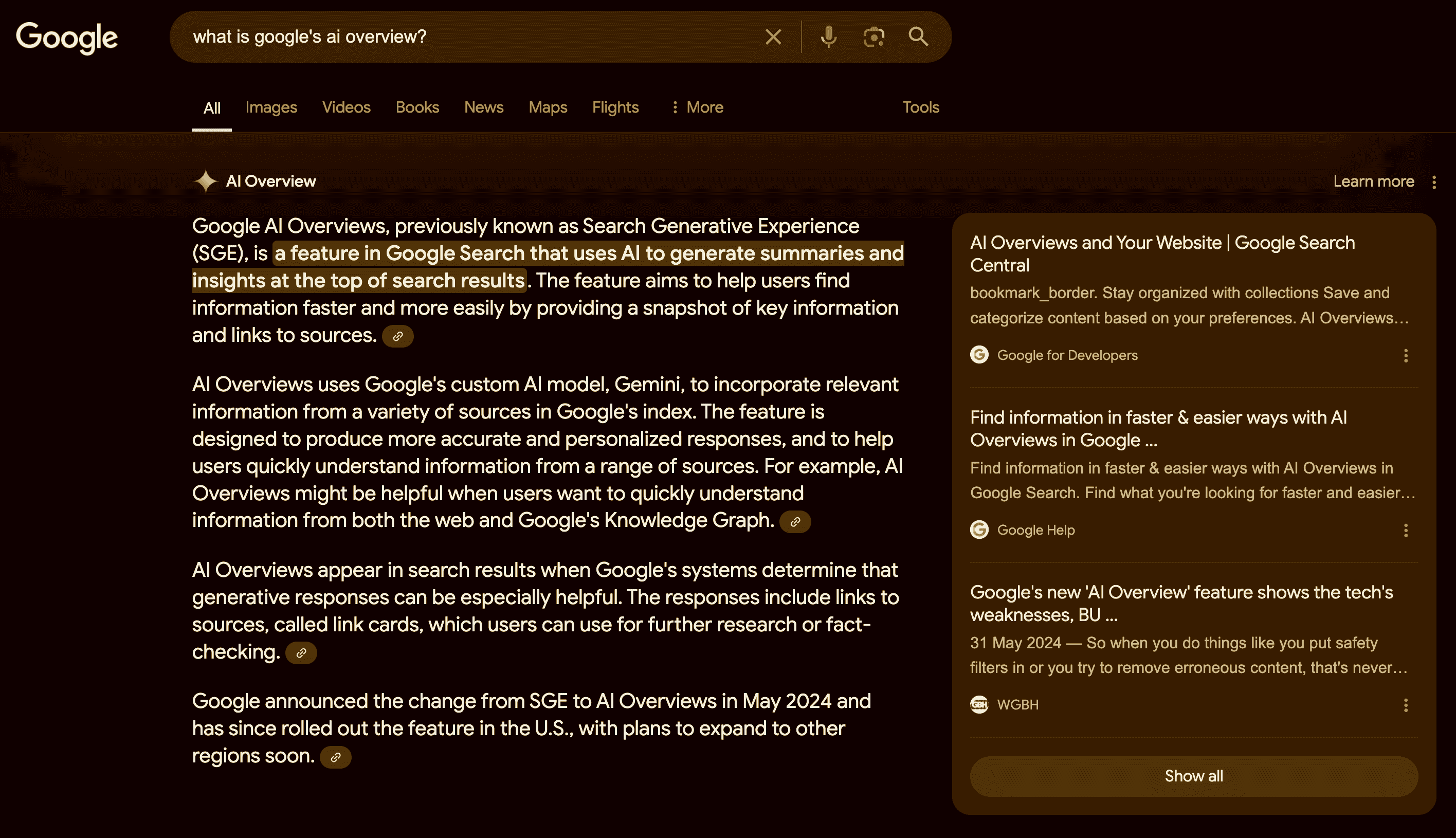

Google'ın "İnsanlar da Soruyor" özelliği, arama sonuçlarında diğer kaynaklardan gelen ilgili soruları ve yanıtları gösteren bir bölümdür. Kullanıcıların sorguları hakkında daha fazla bilgi bulmalarına veya konunun farklı yönlerini keşfetmelerine yardımcı olur.

Bu özellik dinamiktir ve kullanıcının etkileşimine bağlı olarak genişleyebilir veya değişebilir.

SEO'nuzu Güçlendirmek için PAA Sorularını Kullanma

"People Also Ask" (PAA) esas olarak bir son kullanıcı özelliği olsa da, sitenizin içeriğini oluştururken ve optimize ederken harika bir müttefik olabilir.

PAA'nın arkasındaki fikir, kullanıcıların sorguları hakkında ek bilgi bulmalarına yardımcı olmak veya bir bilgiyi nasıl arayacaklarından emin olmayan kayıp kullanıcılara yardımcı olmaktır, bu nedenle Google'ın aramanın arkasındaki amacı "tahmin etmesi" gerekir.

Şimdi anladınız mı?

PAA soruları, içeriğinizin yanıtlaması gereken potansiyel soruları belirlemenin - konu otoritesini artırmanın - veya ana anahtar kelimeniz etrafında içerik oluşturmak için yeni konuları belirlemenin harika bir yoludur.

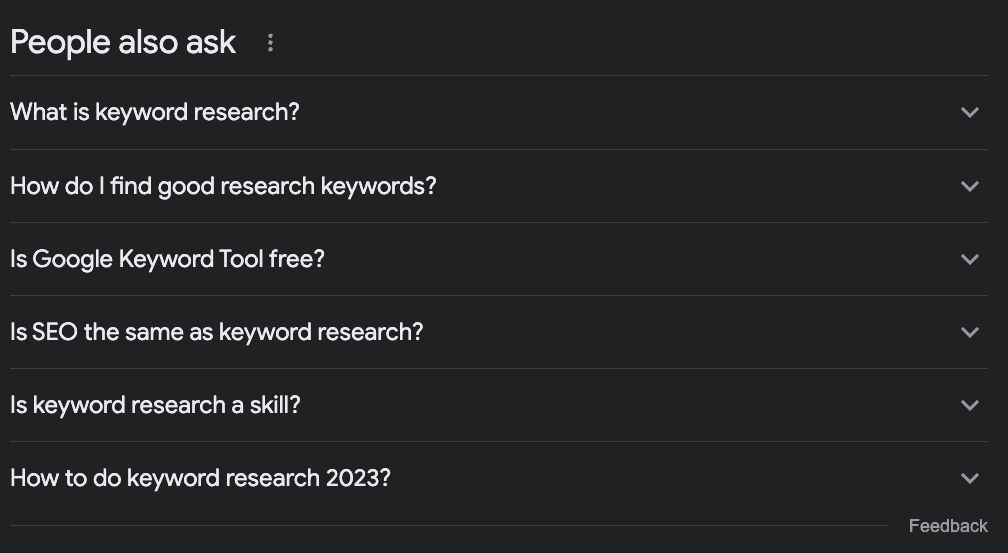

Örneğin, anahtar kelime araştırması yapmakla ilgili bir yazı yazmak istediğinizi varsayalım. Neleri ele almalısınız?

Çoğu kişi hedef terimi Google'da aratacak, halihazırda sıralamada olanlara bakacak ve bir gün diyecektir.

Ancak, PAA kutusunu işaretlersek bazı ilginç fikirler bulabiliriz:

Anahtar kelime araştırması nedir?

İyi araştırma anahtar kelimelerini nasıl bulabilirim?

Google Anahtar Kelime Aracı ücretsiz mi?

SEO anahtar kelime araştırması ile aynı şey midir?

Anahtar kelime araştırması nasıl yapılır 2023?

Yalnızca bu sorulardan bile birkaç şey belirleyebiliriz:

"SEO, anahtar kelime araştırmasıyla aynı şey midir?" sorusu bize bunun çok giriş seviyesinde bir konu olduğunu, dolayısıyla bu terimi arayan kişilerin yeni başlayanlar olduğunu ve onlar için tonu belirlememiz gerektiğini söylüyor.

İçinde bulunduğumuz yılla ilgili bir sorumuz olduğu için sık sık güncellenmesi gereken, gelişmekte olan bir konudur.

"Anahtar Kelime Araştırması Nedir?" ve "İyi Arama Anahtar Kelimelerini Nasıl Bulurum?" başlıklarını içeren bir bölüm eklemeliyiz - ikincisini tam olarak böyle kullanmazdım ama siz anladınız.

Google sorguya bağladığı için eğitimin bir parçası olarak "Google Anahtar Kelime Planlayıcı "nın nasıl kullanılacağından bahsetmeliyiz.

Anahtar kelimelerimiz hakkında pek çok değerli bilgi edinebilir, ilgili anahtar kelimelerin bir listesini oluşturabilir, içeriğimizi hedef anahtar kelime etrafındaki yaygın soruları yanıtlayacak şekilde optimize edebilir ve eksiksiz konu kümeleri oluşturmak için yeni konu fikirleri bulabiliriz.

Python ile "İnsanlar da Soruyor" Sorularını Toplama

Yine de bir zorluk var. Mevcut içeriğimiz için veya içeriğimizi planlarken destek olarak kullanmak üzere tüm bu soruları toplamak zaman alıcı ve yoğun kaynak gerektiren bir iştir.

SEO'lar ve içerik yöneticileri ekstra araştırma eklemek için zaten çok fazla iş yapıyor, peki bunu nasıl çözeceğiz?

Basit, süreci otomatikleştiriyoruz!

Bir web kazıyıcı oluşturacağız:

Anahtar kelimelerin bir listesini alın

Anahtar kelimenin SERP'ine gidin

Tüm PAA sorularını çıkarın

Bilgileri bir CSV'ye aktarın

Bu eğitimde, tüm karmaşıklığı halletmek için basit bir araçla Python kullanacağız ve ortaya çıkan kodu sadece anahtar kelimeleri değiştirerek kullanabileceksiniz.

Hazır mısınız? Hadi başlayalım.

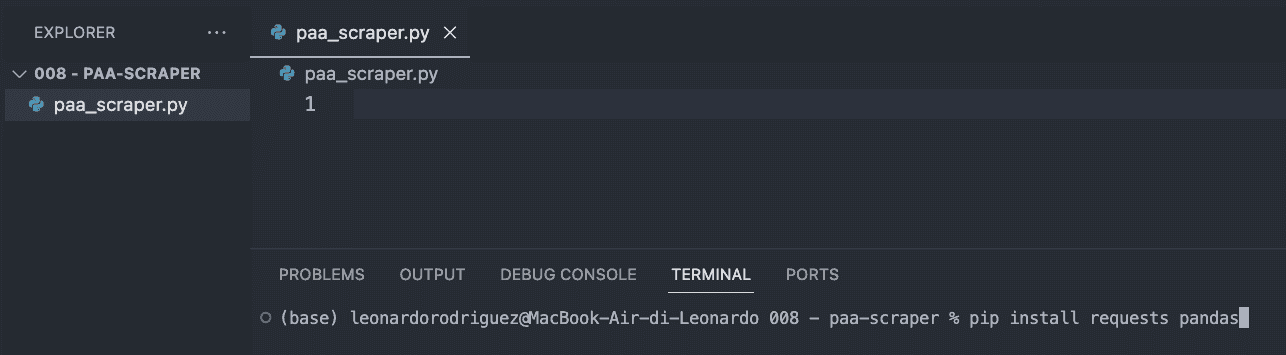

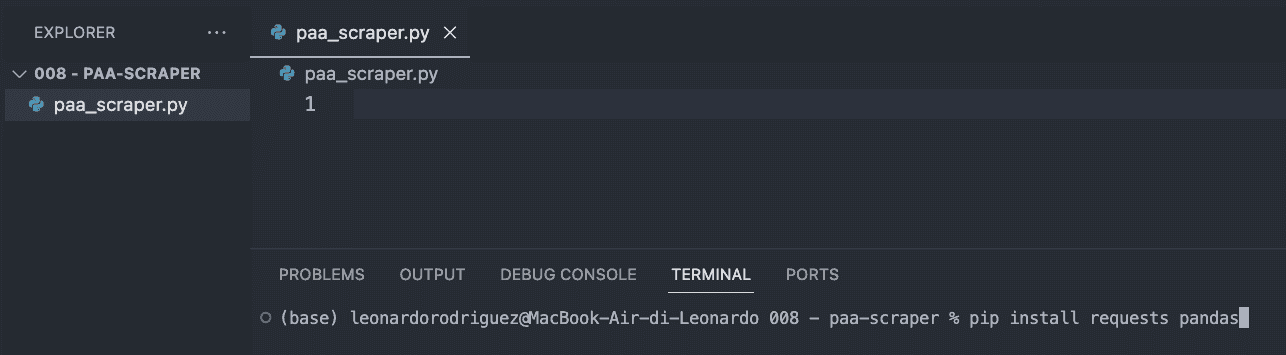

Adım 1: Projenizi Kurun

Yapmanız gereken ilk şey projeniz için yeni bir klasör oluşturmak (paa-scraper olarak adlandırın) ve içinde yeni bir paa_scraper.py dosyası oluşturmaktır.

Mac kullanıyorsanız, makinenizde zaten bir Python sürümü yüklüdür. Windows kullanıyorsanız, makinenize kurmak için bu öğreticiyi takip edin.

Ardından, VScode'daki klasörü ve yeni bir terminal açın.

Oradan aşağıdaki komutu girin.

pip install requests pandasYukarıdaki komut iki faydalı aracı (bağımlılıkları) yükleyecektir:

Requests, ayıklamak istediğimiz bilgileri istememize izin verecek

Pandas, bilgileri CSV dosyası olarak dışa aktarmamıza yardımcı olacaktır

Bu adımı tamamlamak için, dosyanın üst kısmındaki her iki bağımlılığı da içe aktarın.

import requests import pandas as pdAdım 2: ScraperAPI Aracılığıyla Talebimizi Gönderme

Geleneksel olarak, aradığımız verileri elde etmek için Google'a giden bir kazıyıcı oluşturmamız, CSS seçicileri kullanarak bilgileri aramamız, bilgileri seçmemiz, biçimlendirmemiz gerekir... ne demek istediğimi anlıyor musunuz? Bu genellikle çok fazla mantık gerektirir.

Bunun yerine, maliyetleri, uygulama süresini ve bakımı azaltmak için bir web kazıma aracı kullanabiliriz.

İsteğimizi ScraperAPI'nin yapılandırılmış veri uç noktaları aracılığıyla göndererek, HTML'yi ayrıştırma, engellenme veya karşılaşabileceğimiz diğer sorunlar hakkında endişelenmeden herhangi bir sorgunun PAA sorularını alabileceğiz.

Başlamak için ücretsiz bir ScraperAPI hesabı oluşturun ve API anahtarınızı kopyalamak için kontrol panelinize gidin.

Ardından, aşağıdaki gibi bir payload oluşturacağız:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }Ülke parametresi ScraperAPI'ye isteklerinizi nereden göndereceğinizi söyleyecektir - Google'ın konumunuza göre farklı sonuçlar gösterdiğini unutmayın - sorgu parametresi ise anahtar kelimenizi tutar.

Bu parametreler hazır olduğunda, get() yöntemini kullanarak isteğimizi gönderebiliriz:

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Adım 3: PAA Sorularını Yazdırma

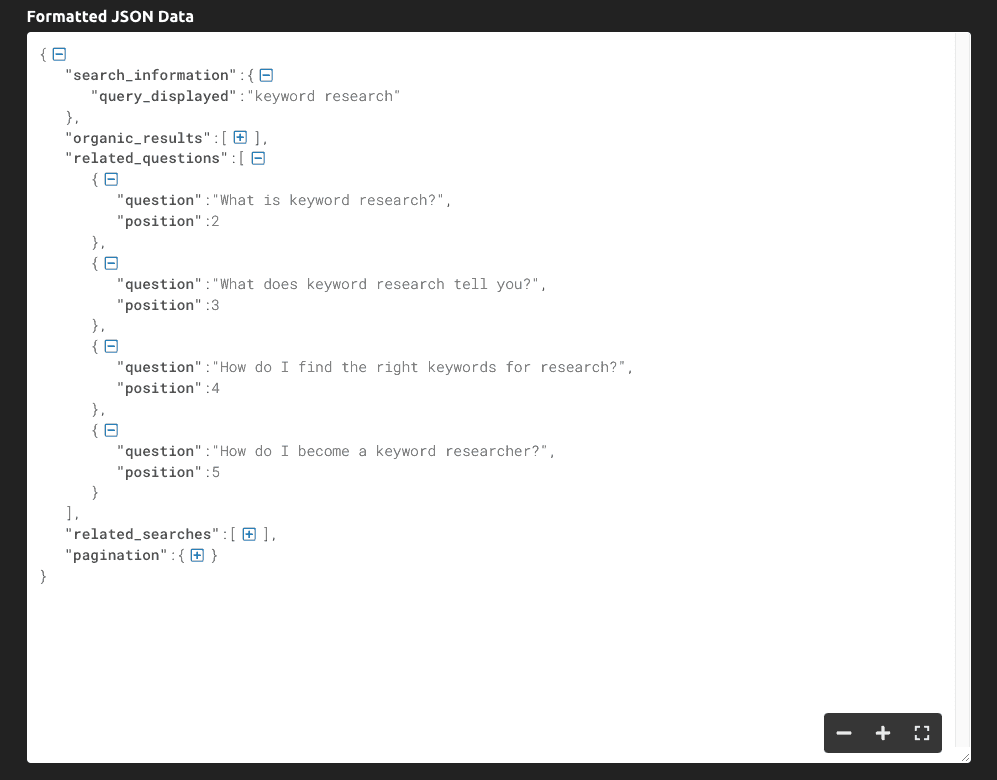

Eğer print(response.text) yaparsak, elde ettiğimiz bilgi budur:

Gördüğünüz gibi, araç tüm SERP'i JSON verisi olarak döndürüyor ve sorguyla ilgili ana sorular "related_questions" anahtarının içinde yer alıyor.

Ham HTML verisi yerine yapılandırılmış veri elde ettiğimiz için, anahtar adlarını kullanarak belirli öğeleri seçebiliriz:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])JSON yanıtının tamamını bir serp değişkeninde saklıyoruz

"related_questions "ı alıyoruz ve her bir öğenin bir PAA sorusu olduğu bir öğe listesi oluşturuyoruz

Soruları almak için listede döngü oluşturuyoruz ve yalnızca "soru" anahtarını yazdırıyoruz

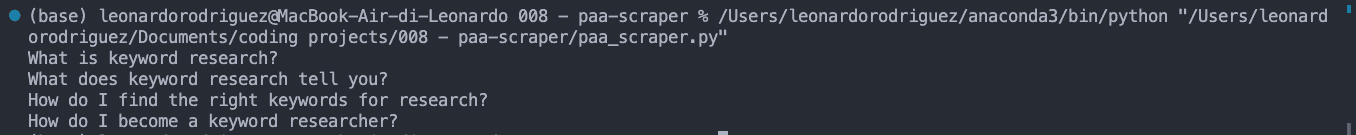

Bunun sonucu, konsolda yazdırılan PAA sorularının bir listesidir:

Adım 4: Verileri CSV Dosyasına Aktarma

CSV dosyası için, anahtar kelimeyi PAA sorusuyla eşleştirmek de isteyebiliriz, bu yüzden onu alalım:

keyword = serp['search_information']['query_displayed']Bu işlem tamamlandıktan sonra, verileri istediğimiz gibi biçimlendirmek için kullanacağımız boş bir liste oluşturacağız:

paa_sorular = []Ve çıkarılan bilgileri buna ekleyin:

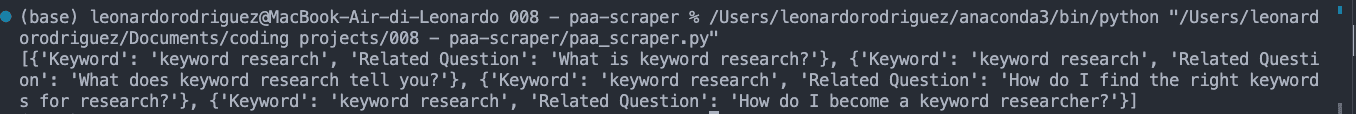

for paa in all_questions: paa_questions.append({ 'Anahtar Kelime': anahtar kelime, 'İlgili Soru': paa['soru'] })Eğer paa_questions'ı yazdırırsak, konsolda nasıl göründüğü aşağıda verilmiştir:

Bu önemli çünkü CSV dosyasının temelini oluşturuyor ve kazıyıcıyı binlerce anahtar kelimeye genişlettiğimizde sorunun nereden geldiğini belirlememize yardımcı olacak.

Son adımda, kolay dışa aktarım için Pandas kullanarak CSV dosyasını oluşturalım:

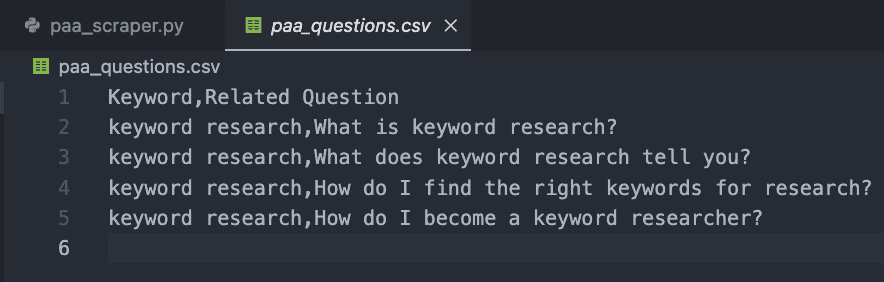

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Kodunuzu şimdi çalıştırırsanız, konsola hiçbir şey yazdırmayacaktır. Bunun yerine, aşağıdaki gibi yeni bir CSV dosyası oluşturacaktır:

Adım 5: PAA Sorularını Ölçekli Olarak Toplama

Elbette, sadece bir anahtar kelime için soruları almak elle yapılabilir, peki bu projeyi nasıl ölçeklendireceğiz?

İşte web kazımanın güzelliği. Her şey döngü ile ilgili!

İlk olarak, istediğiniz anahtar kelimeleri içeren bir liste oluşturun:

keywords = { 'keyword+research', 'keyword+tracker' }Ardından, önceki tüm kodlarımızı anahtar kelimeler listesindeki her bir terimi alacak ve tüm süreci çalıştıracak yeni bir döngünün içine koyacağız.

İşte son ve tam kod parçacığı:

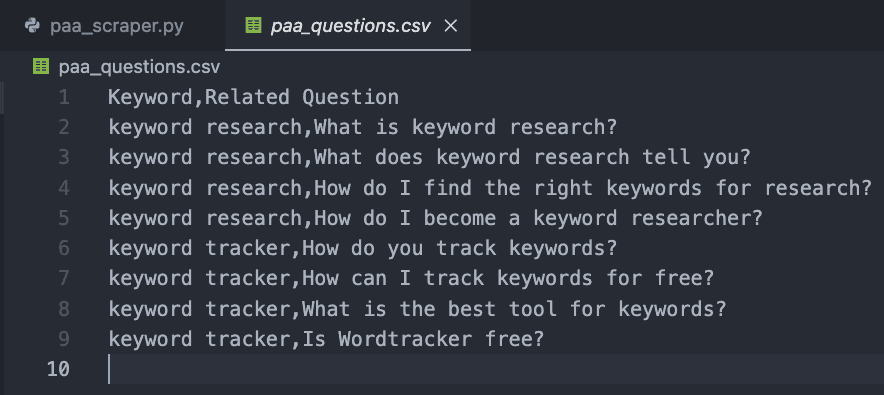

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Test amacıyla biz sadece iki tane ekledik, ancak siz binlerce hatta milyonlarca hedef anahtar kelimeden oluşan bir liste oluşturabilirsiniz.

Sonuç, okunması kolay bir CSV dosyasıdır:

Tebrikler, ilk 9 PAA sorunuzu topladınız! 🎉

Toparlıyoruz

Bu makalede, nasıl yapılacağını öğrendiniz:

Yeni bir Python kazıyıcı başlatma

ScraperAPI aracılığıyla HTTP istekleri gönderme

Belirli veri noktaları seçin

Çıkarılan verileri biçimlendirme

Verileri bir CSV dosyasına aktarın

API anahtarınızı ve anahtar kelime listenizi keywords değişkeninin içine ekleyerek yukarıdaki kodu kendinize ait hale getirebilirsiniz. Aynı mantığı her hedef anahtar kelime için en üst sıraları toplamak için de kullanabilir, bu işlemleri otomatikleştirerek araştırma çabalarınızı ölçeklendirebilirsiniz.

Kodlama ile uğraşmak istemiyorsanız, tek bir satır kod yazmadan tüm kazıma projelerini otomatikleştirmek için tasarlanmış kodsuz bir araç olan ScraperAPI'nin DataPipeline'ını da kullanabilirsiniz. Sadece anahtar kelime listenizi ekleyin ve gerisini aracın yapmasına izin verin.

Sitenizin içeriğini geliştirmek için PAA sorularını toplamak ve kullanmak, çoğu SEO uzmanının göz ardı ettiği gizli bir silahtır. Nasıl kullanacağınızı biliyorsanız veriler en iyi dostunuzdur, bu nedenle yaratıcı olun ve alanınıza hakim olmak için sınırları zorlayın!

SEO çalışmalarınızı takip etmek için bir yola mı ihtiyacınız var? Accuranker ücretsiz deneme sürümünüzü başlatın ve birkaç tıklamayla SEO kampanyanızın tam resmini elde edin.

Makale tarafından:

Leonardo

ScraperAPI'da Baş Teknik Yazar

Leo, İtalya'da yaşayan, Python ve Node.js deneyimi olan bir teknik içerik yazarıdır. Şu anda ScraperAPI 'de baş teknik yazar ve içerik yöneticisi olarak çalışmaktadır.